-divergence

다음과 같이 정의되는 -divergence는 두 확률 분포를 밀도 비율의 측면에서 비교한다. -divergence는 -divergence라고도 불린다.

여기서 은 을 만족하는 볼록 함수이다. Jensen의 부등식로부터 을 따르고 이다. 따라서 는 유효 다이버전스이다.

KL divergence

를 사용해서 -divergence를 계산하면 Kullback-Leibler divergence가 된다.

Alpha divergence

인 -divergence는 다음과 같은 alpha divergence가 된다. 여기서 이다.

다른 일반적인 파라미터화는 다음과 같이 Minka가 사용한 것이다.

이것은 을 사용하여 Amari의 표기법으로 변환할 수 있다. 여기서

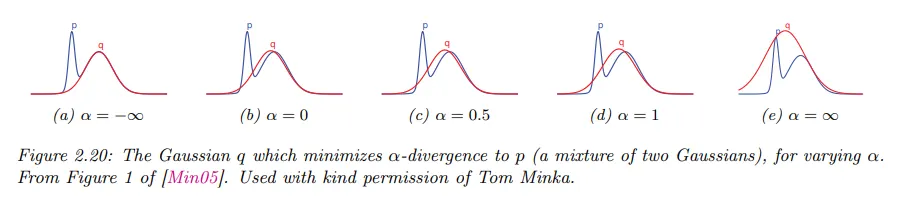

아래 그림에서 에 따라 는 의 한 mode와 일치하는 것을 선호하는 반면, 이면 는 의 모든 부분을 커버하는 것을 선호한다는 것을 볼 수 있다. 더 정확하게 이면 alpha divergence는 가 되는 경향이 있고 이 되면 alpha divergence는 가 되는 경향이 있다. 또한 에서 alpha divergence는 Hellinger 거리와 같아진다.

Hellinger distance

(squared) Hellinger distance는 다음과 같이 정의된다.

이것은 대칭이고 음이 아니고 삼각 부등식을 만족하기 때문에 유효한 거리 메트릭이다.

이것이 인 -divergence와 (상수 인자까지) 동등함을 볼 수 있다.

Chi-squared distance

chi-squared distance 은 다음처럼 정의된다.

이것이 인 -divergence와 (상수 인자까지) 동등함을 볼 수 있다.