Abstract

최첨단 computer vision 시스템은 사전에 정의된 object 카테고리의 고정된 집합을 예측하도록 학습된다. 이러한 제한된 supervision의 형식은 일반화와 사용성에 제한하며 다른 시각적 컨셉을 지정하려면 추가적인 라벨링된 데이터가 필요하다. 이미지에 대한 raw 텍스트에서 직접 학습하는 것은 훨씬 광범위한 supervision의 소스를 활용할 수 있는 유망한 대안이다. 우리는 이미지에 어떤 캡션이 맞는지 예측하는 간단한 pre-training task가 인터넷에서 수집된 400M (이미지, 텍스트) 쌍의 데이터셋에서 SOTA 이미지 representation을 처음부터 효율적이고 확장 가능하게 학습하는 방법임을 시연한다. pre-training 후에는 자연어를 사용하여 학습된 시각 컨셉(또는 새로운 개념을 설명하는)을 참조하는데 사용되어, 모델이 추가 학습 없이도 다양한 downstream task에 zero-shot transfer을 가능하게 한다. 우리는 OCR, 비디오에서 액션 인식, geo-localization과 다양한 세분화된 object 분류와 같은 작업을 포함하여 30개 이상의 기존 computer vision 데이터셋에서 이러한 접근의 성능을 벤치마크하여 연구했다. 이 모델은 대부분의 작업에 비자명하게 전이되고 특정한 데이터셋 학습 없이도 종종 fully supervised baseline과 경쟁력 있다. 예컨대 우리는 1.28M 학습 예제의 사용 없이도 ImageNet에서 zero-shot으로 오리지날 ResNet-50의 정확도와 일치한다. 우리는 우리 코드와 pre-trained model 가중치를 git에서 공개한다.

1. Introduction and Motivating Work

raw text에서 직접 학습하는 pre-training은 지난 몇 년간 NLP에 혁신을 가져왔다. autoregressive와 masked language modeling 같은 task-agnostic 목적은 계산, 모델 용량, 데이터 측면에서 수많은 차원으로 확장되어 성능을 꾸준히 확장시켰다. ‘text-to-text’를 표준화된 입력-출력 인터페이스로 개발한 것은 task-agnostic 아키텍쳐가 downstrema 데이터셋에 zero-shot으로 transfer 할 수 있도록 하여, 특수한 출력 head나 데이터셋 맞춤에 대한 필요를 없앴다. GPT-3 같은 Flagship 시스템은 이제 많은 task에서 bespoke 모델과 경쟁력 있으면서 데이터셋 특정 학습 데이터를 거의 또는 전혀 필요 없다.

이러한 결과는 web-scale 텍스트 수집 내에서 현대 pre-training 방법이 접근할 수 있는 aggregate supervision이 고품질의 crowd-라벨링된 NLP 데이터셋을 능가한다는 것을 시시한다. 그러나 computer vision 같은 다른 영역에서 여전히 ImageNet 같은 crowd-라벨링된 데이터셋에서 모델을 pre-train 하는 것이 표준 관례이다. 웹 텍스트에서 직접 학습하는 확장 가능한 pre-training 방법이 computer vision에서 유사한 breakthrough일 수 있을까? prior 작업은 고무적이다.

20년 전 Mori et al(1999)는 이미지와 쌍을 이룬 텍스트 문서에서 명사와 형용사를 예측하도록 모델을 학습시켜서 컨텐츠 기반 이미지 검색을 개선하는 것을 탐구했다. Quattoni et al(2007)은 이미지와 연관된 캡션에서 단어를 예측하도록 학습된 분류기의 가중치 공간에서 manifold learning을 통해 데이터 효율적 이미지 representation을 학습하는 것이 가능함을 보였다. Srivastava & Salakkhutdinov(2012)는 low-level 이미지와 텍스트 tag feature 위에 multimodal Deep Boltzmann Machine을 학습하여 deep representation learning을 탐구했다. Joulin et al(2016)은 이러한 연구들을 현대화하여 이미지 캡션에서 단어를 에측하도록 학습된 CNN이 유용한 이미지 representation을 학습함을 보였다. 그들은 YFCC100M 데이터셋에서 이미지의 title, description, hashtag metadata를 bag-of-word multi-label 분류 작업으로 변환하여, 이러한 라벨을 예측하도록 AlexNet을 pre-training하는 것이 transfer 작업에서 ImageNet-based pre-training에 유사하게 수행되는 것을 보였다. Li et al(2017)은 이러한 접근을 확장하여 구문 n-gram을 예측했으며, 학습된 visual n-gram의 사전에서 기반하여 target class를 scoring하여 가장 높은 score를 예측하는 방식으로 다른 이미지 classification 데이터셋에서 zero-shot transfer 할 수 있음을 시연했다. 최근 아키텍쳐와 pre-training 접근을 채택한 VirTex, ICMLM과 ConVIRT는 transformer 기반 언어 모델링, masked language modeling과 contrastive 목적을 통해 텍스트에서 이미지 representation을 학습하는 잠재력을 보였다.

PoC가 흥미롭지만, 자연어 supervision을 사용하는 이미지 representation 학습은 여전히 드물다. 이것은 아마도 일반적인 벤치마크에서 시연된 성능이 대안 접근 보다 훨씬 낫기 때문일 것이다. 예컨대 Li et al(2017)은 zero-shot 설정에서 ImageNet에서 11.5% 정확도에 도달했다. 이것은 현재 최첨단 접근의 88.4%에 비해 한참 아래이고, 전통적인 computer vision 접근의 50% 보다도 낮다. 대신 좁은 범위이지만 잘 타겟팅된 weak supervision의 사용은 성능을 개선한다. Mahajan et al(2018)은 Instagram이미지에서 ImageNet-관련 hashtag를 예측하는 것이 효율적인 pre-training 학습임을 보였다. 이러한 pre-train 모델을 ImageNet에 fine-tune 할 때 5% 이상 정확도가 개선되어 당시 최첨단을 개선한다. Kolesnikov et al(2019)와 Dosovitskiy et al(2020)도 JFT-300M 데이터셋의 noisily 라벨링을 예측하는 방식으로 더 광범위한 transfer 벤치마크에서 큰 성과를 얻었다.

이 연구 방향은 제한된 양의 supervised ‘gold-label’에서 학습과 무제한의 raw text에서 학습하는 것 사이의 실용적인 중간 중간지점을 나타낸다. 그러나 타협점이 없는 것은 아니다. 두 연구 모두 supervision을 각각 1000과 18291의 클래스에 맞추도록 신중하게 설계하면서 동시에 이를 제한한다. Natural language는 더 일반적이므로 훨씬 광범위한 시각적 컨셉을 표현하고 supervise 할 수 있다. 또한 두 접근 모두 예측을 수행하기 위해 정적 softmax 븐류기를 사용하며 동적 출력에 대한 메커니즘이 부족하다. 이는 유연성을 심각하게 제한하며 ‘zero-shot’ 능력을 제약한다.

이러한 weakly supervised 모델과 자연어에서 직접적으로 image representation을 학습하는 최근 탐구 사이의 핵심적인 차이는 scale이다. Mahajan et al(2018)과 Kolesnikov et al(2019)는 수백 만에서 수십 억 이미지로 모델을 수 년간 학습했지만, VirTex, ICMLM, ConVIRT는 수십 만장의 이미지로 며칠간만 학습했다. 이 연구에서 우리는 이 격차를 좁히고 대규모에서 자연어 supervision을 사용하여 학습된 이미지 분류기의 동작을 연구한다. 인터넷에서 이러한 형식의 데 공개 데이터를 대량으로 이용할 수 있게 되어, 우리는 400M의 (이미지, 텍스트) 쌍으로 이루어진 새로운 데이터셋을 생성하고, ConVIRT의 단순화 버전을 처음부터 학습시킨 CLIP(Contrastive Language-Image Pre-training의 약자)이 자연어 supervision에서 효율적인 학습 방법임을 보인다. 우리는 2차례 정도의 계산량 차이를 두고 8개 모델 계열을 학습하여 CLIP의 확장성을 연구하고, transfer 성능이 계산량의 스무스하게 예측 가능한 함수임을 관찰한다. 우리는 CLIP이 GPT 계열과 유사하게 pre-training 동안 OCR, geo-localization, action recognition 등 광범위한 작업을 수행하는 법을 학습한다는 것을 발견한다. 우리는 이것을 30개 이상 기존 데이터셋에서 CLIP의 zero-shot transfer 성능을 벤치마킹하여 측정했으며 prior task별 supervised 모델과 경쟁할 수 있음을 발견한다. 또한 linear-probe representation learning 분석을 사용하여 CLIP이 공개적으로 사용 가능한 최고의 ImageNet 모델을 능가하며 더 계산 효율적임을 보인다. 우리는 추가적으로 zero-shot CLIP 모델이 동일한 정확도를 가진 supervised ImageNet 모델 보다 훨씬 더 견고함을 발견하고, 이것은 task-agnostic 모델의 zero-shot 평가가 model의 능력을 더 잘 나타냄을 시사한다. 이 결과는 중요한 정책적이고 윤리적인 함의를 가지며, 이를 섹션 7에서 논의한다.

2. Approach

2.1. Natural Language Supervision

우리 접근의 핵심은 자연어에 포함된 supervision을 통해 인식을 학습하는 아이디어이다. 소개에서 논의한 대로 이것은 완전히 새로운 아이디어가 아니지만 이 분야의 연구를 설명하는 terminology는 다양하고 모순되는 것처럼 보이기도 하며 선언된 동기도 다양하다. Zhang et al(2020), Gomez et al(2017), Joulin et al(2016), Desai & Johnson(2020) 모두 이미지와 함께 제공된 텍스트에서 시각 representation을 학습하는 방법을 도입했다. 각각의 접근을 unsupervised, self-supervised, weakly supervised 그리고 supervised라고 설명했다.

우리는 이 작업들에서 공통적인 것은 특정한 방법의 세부사항이 아닌 자연어를 학습 신호로 인식하는 점이라는 것을 강조한다. 이러한 모든 접근은 자연어 supervision에서 학습한다. 초기 작업이 topic 모델과 n-gram representation을 사용할 때 자연어의 복잡성과 씨름했지만, deep contextual representation 학습에서 개선은 우리가 이제 풍부한 supervision 소스를 효율적으로 활용할 수 있는 도구를 가지고 있음을 시사한다.

자연어에서 학습하는 것이 다른 학습 방법에 대해 여러 잠재적 강점을 가진다. 이미지 분류를 위한 표준 crowd-소스 라벨링 보다 자연어 supervision이 훨씬 쉽게 확장될 수 있다. 이는 ‘기계 학습 호환 가능한 포맷’, 즉 전통적인 1-of-N 투표 ‘gold label’과 같은 주석이 필요 없기 때문이다. 대신 자연어를 사용하는 방법은 인터넷에서 방대한 양의 텍스트에 포함된 supervision에서 수동적으로 학습할 수 있다. 또한 자연어에서 학습하는 것은 대부분의 unsupervised 또는 self-supervised 학습 접근에 대해 중요한 이점을 갖는다. 그것은 단순히 representation만 학습하는 것이 아니라 그 representation을 언어와 연결하여 유연한 zero-shot 전이를 가능하게 한다는 것이다. 이후 섹션에서 우리가 선택한 구체적인 접근을 설명한다.

2.2. Creating a Sufficiently Large Dataset

기존 작업은 주로 3가지 데이터셋을 갖는다. MS-COCO, Visual Genome, YFCC100M. MC-COCO와 Visual Genome이 고품질 crowd-라벨링 데이터셋이지만 각각 약 100,000개 학습 사진만 포함하여 현대 표준에 비해 크기가 작다. 반면 다른 computer vision 시스템은 3.5B 인스타그램 사진에서 학습된다. YFCC100M은 100M 사진으로 가능한 대안이지만 각 이미지의 메타데이터는 희소하고 품질이 일정하지 않다. 많은 이미지가 ‘title’로 20160716 113957.JPG 같이 자동적으로 생성된 파일이름을 사용하거나 카메라 exposure 설정의 ‘description’을 포함한다. 자연어 title과/또는 description을 영어로 갖는 이미지만 남기기 위해 필터링한 후에, 데이터셋은 1/6로 줄어 15M의 사진만 남는다. 이것은 ImageNet과 거의 동일한 크기이다.

자연어 supervision의 주요 동기는 인터넷에서 공개적으로 제공되는 이런 형식의 방대한 양의 데이터이다. 기존 데이터셋은 이러한 가능성을 충분히 반영하지 않기 때문에 이들의 결과만 고려하면, 이 연구 방향의 잠재적을 과소평가한다. 이것을 해결하기 위해 우리는 인터넷에서 공개적으로 접근 가능한 다양한 소스에서 수집된 400M의 (이미지, 텍스트) 쌍의 새로운 데이터셋을 구축한다. 가능한 광범위한 시각 컨셉을 커버하기 위해, 텍스트에 500,000개 쿼리 중 하나가 포함된 (이미지, 텍스트) 쌍을 찾는 과정을 데이터셋 구축 과정의 일부로 진행했다. 우리는 쿼리 당 최대 20,000개 (이미지, 텍스트) 데이터를 포함시켜 대략적으로 클래스 균형을 맞춘다. 결과적으로 만들어진 데이터셋의 전체 단어 수는 GPT-2를 학습하는데 사용된 WebText 데이터셋과 유사하다. 우리는 이 데이터셋을 WebImageText의 약자인 WIT로 부른다.

2.3. Selecting an Efficient Pre-Training Method

최첨단 computer vision 시스템은 매우 많은 계산양을 사용한다. Mahajan et al(2018)은 ResNeXt101-32x48d를 학습하는데 19년치의 GPU 계산 자원이 필요했고, Xie et al(2020)은 Noisy Student EfficientNet-L2를 학습하는데 33년치 TPUv3 core 자원이 필요했다. 이 둘 모두 1000개의 ImageNet 클래스에만 예측하기 위해 학습되었다는 점을 고려하면, 자연어에서 시각 컨셉의 열린 집합을 학습하는 작업은 막대해 보인다. 우리의 노력의 과정에서 학습 효율성이 자연어 supervision을 성공적으로 확장하는데 핵심임을 발견하고 이 메트릭에 기반하여 우리의 최종 pre-training 방법을 선택했다.

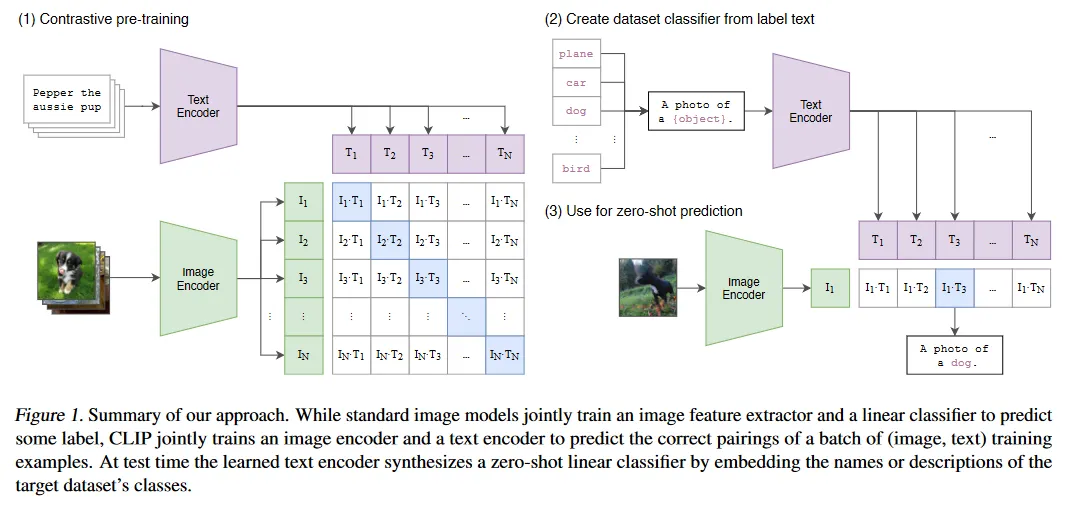

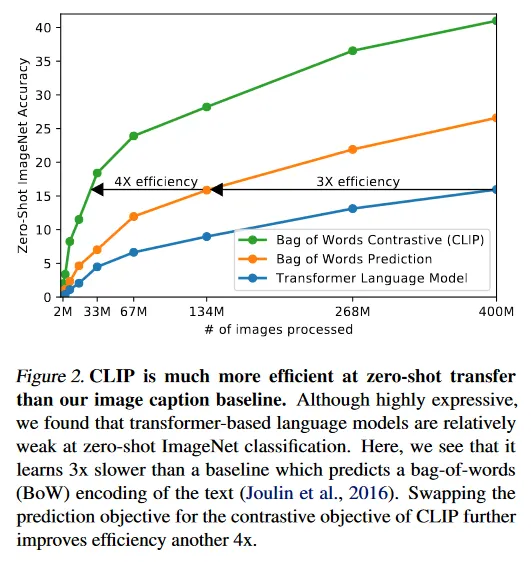

우리의 초기 접근은 VirTex와 유사하게 이미지의 캡션을 예측하기 위해 이미지 CNN과 text transformer를 결합하여 처음부터 학습하는 것이었다. 그러나 이 방법을 효과적으로 스케일링하는데 어려움을 마주했다. 그림 2에서 우리는 63M 파라미터 Transformer 언어 모델이 ResNet-50 이미지 encoder의 두 배에 해당하는 계산량을 사용하면서도 ImageNet 클래스를 인식하는 속도가 동일한 텍스트의 bag-of-words encoding을 예측하는 훨씬 단순한 baseline보다 3배 느리다는 것을 보인다.

이 두 접근 모두 중요한 유사성을 공유한다. 두 방식 모두 각 이미지에 수반되는 텍스트의 정확한 단어를 예측하려고 시도한다. 이는 이미지와 함께 나타나는 다양한 description, comment 및 관련 텍스트 때문에 어렵다. 최근 이미지에 대한 contrastive representation learning에서 contrastive 목적이 동일한 예측 목적과 비교하여 representation을 더 잘 학습할 수 있음을 발견했다. 다른 작업에서 이미지의 생성 모델이 고품질 이미지 representation을 학습할 수 있음을 발견했지만 동일한 성능을 갖는 contrastive 모델 보다 10배 이상 많은 계산량을 필요로 한다. 이러한 발견에 유의하여 우리는 전체 텍스트가 어느 이미지와 쌍을 이루는지만 예측하는, 즉 텍스트의 정확한 단어를 예측하지 않는 잠재적으로 더 쉬운 proxy task를 해결하도록 시스템을 학습하는 방법을 탐구했다. 동일한 bag-of-word encoding baseline에서 시작하여, 예측 목적을 contrastive 목적으로 교체한 결과 그림 2에서 보듯이 ImageNet에 대한 zero-shot transfer의 속도가 4배 더 효율적으로 개선된다.

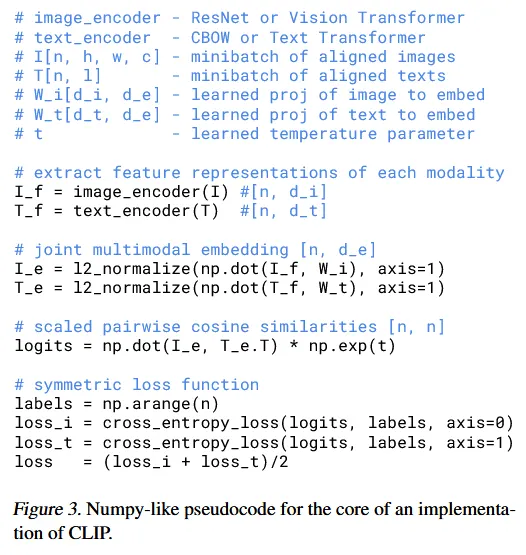

CLIP은 개의 (이미지, 텍스트) 쌍으로 이루어진 배치가 주어지면 개의 가능한 (이미지, 텍스트) 쌍 중 실제 발생한 쌍을 예측하도록 학습된다. 이를 위해 CLIP은 이미지 encoder와 텍스트 encoder를 결합으로 학습하여, 배치 내의 개의 실제 쌍의 이미지와 텍스트 embedding의 cosine 유사도를 최대화하고, 잘못된 쌍의 embedding의 cosine 유사도를 최소화하는 방식으로 multi-modal embedding 공간을 학습한다. 우리는 이러한 유사도 score에 대해 대칭 cross entropy loss를 최적화한다. 그림 3에서 CLIP의 구현의 핵심에 대한 pseudocode를 포함한다. 우리가 아는 한 이 batch 구성 기법과 목적은 처음에 Sohn(2016)에 의해 deep metric learning의 분야에서 Multi-Class N-pair loss로 도입되었고, Oord et al(2018)에서 contrastive representation learning을 위한 InfoNCE loss로 대중화되었으며, 최근에는 Zhang et al(2020)이 의료 이미지의 도메인에서 contrastive (텍스트, 이미지) representation learning에 적용시켰다.

pre-training 데이터셋의 큰 크기 때문에 과적합은 주요 염려가 아니고 CLIP 학습의 세부사항은 Zhang et al(2020)의 구현보다 간단하다. 우리는 이미지 encoder를 ImageNet 가중치로 초기화하지 않고, 텍스트 encoder도 pre-trained 가중치 없이 CLIP을 처음부터 학습했다. 또한 Bach-man et al(2019)에 의해 도입되고 Chen et al(2020b)에 의해 대중화된 representation과 contrastive embedding 공간 사이의 비선형 projection을 사용하지 않는다. 대신 각 encoder의 representation을 multi-modal embedding 공간으로 매핑하기 위한 선형 투영만 한다. 두 버전 사이의 학습 효율성 차이는 없었으며, 비선형 투영이 현재의 self-supervised representation learning 방법에서 이미지의 전용 세부 사항과 공동으로 적용될 수 있다고 추측한다. 또한 Zhang et al(2020)에서 도입된 텍스트에서 균등하게 단일 문장을 샘플링하는 text 변환 함수 를 제거하는데, 이는 CLIP의 pre-training 데이터셋에서 많은 (이미지, 텍스트) 쌍이 단일 문장이기 때문이다. 우리는 또한 이미지 변환 함수 도 단순화 한다. resized 이미지에서 무작위 정사각 crop이 학습하는 동안 사용된 유일한 data augmentation이다. 마지막으로 softmax에서 logt의 범위를 제어하는 temperature 파라미터 는 하이퍼파라미터로 튜닝하는 대신, log-파라미터화된 곱셈 스칼라로 학습하는 동안 직접 최적화 된다.

2.4. Choosing and Scaling a Model

우리는 이미지 encoder를 위해 두 가지 아키텍쳐를 고려한다. 첫 번째로 광범위한 적용과 증명된 성능 때문에 image encoder를 위한 base 아키텍쳐로 ResNet-50을 사용한다. 여기서 원래 버전에 대해 He et al(2019)의 Resnet-D와 Zhang(2019)의 antialiased rect-2 blur pooling를 포함한 몇 가지 수정을 한다. 또한 global average pooling을 attention pooling 메커니즘으로 교체한다. attention pooling은 이미지의 global average-pooled representation에 따라 query를 조정하는 ‘transformer-style’ multi-head QKV attention의 단일 레이어로 구현된다. 두 번째 아키텍쳐로는 최근 도입된 Vision Transformer(ViT)를 사용하여 실험한다. 우리는 그들의 구현을 가깝게 따르되, 패치와 position embedding을 transformer 전에 결합하고 추가적인 레이어 normalization을 추가하는 약간의 수정을 한다. 또한 약간 다른 초기화 방식을 사용한다.

텍스트 encoder는 Radford et al(2019)에서 설명된 아키텍쳐 수정을 사용하는 Transformer이다. 기본 크기는 63M 파라미터 12개 레이어 512-wide 모델과 8개 attention head이다. Transformer는 lower-cased byte pair encoding(BPE) 텍스트 representation을 사용하며 어휘 크기는 49,152이다. 계산 효율성을 위해 최대 시퀀스 길이는 76으로 제한되고, 텍스트 시퀀스는 [SOS]와 [EOS] 토큰으로 둘러싸이고, transformer의 가장 높은 레이어에서 [EOS] 토큰의 활성화 값을 텍스트의 feature representation으로 사용한다. 이 값은 layer normalized 한 다음에 multi-modal embedding 공간에 선형 투영된다. 텍스트 encoder에서는 masked self-attention을 사용하여 pre-trained 언어 모델로 초기화하거나 보조 목적으로 언어 모델링을 추가할 수 있는 능력을 보존하지만, 이에 대한 탐구는 미래 작업으로 남긴다.

이전 computer vision 연구가 주로 width나 depth만을 단독으로 증가시켜 모델을 확장했던 반면 ResNet 이미지 encoder의 경우 우리는 Tan&Le(2019)의 접근을 채택한다. 이것은 width, depth와 해상도를 모두 고려하여 추가적인 계산을 할당하는 것이 단일 차원에만 할당하는 것보다 우수한 성능을 낸다고 밝혔다. Tan&Le(2019)가 EfficientNet 아키텍쳐에서 각 차원에 할당된 계산의 비율을 조정하는 반면에 우리는 width, depth, resolution를 동일하게 증가시키는 간단한 baseline을 사용한다. text encoder의 경우 ResNet의 width 증가에 따라 모델의 width만 확장하고 depth는 확장하지 않는다. 이는 CLIP의 성능이 텍스트 encoder의 능력에 덜 민감하다는 것을 발견했기 때문이다.

2.5. Training

우리는 5개 ResNet과 3개 Vision Transformer의 계열을 학습한다. ResNet의 경우 ResNet-50, ResNet-101과 EfficientNet-style 모델을 확장하여 ResNet-50 보다 약 4배, 16배, 64배 계산량을 사용하는 3개 모델을 학습한다. 이 모델들은 각각 RN50x4, RN50x16, RN50x64로 표기된다. Vision Transformer의 경우 ViT-B/32와 ViT-B/16과 ViT-L/14를 학습한다. 모든 모델은 32 epoch 동안 학습된다. 우리는 Adam optimizer를 사용하고, 분리된 weight decay regularization를 gain이나 bias가 아닌 모든 가중치에 적용했고, learning rate decay는 cosine 스케쥴을 사용한다. 초기 하이퍼파라미터는 1 epoch에 대해 학습된 baseline ResNet50 모델을 사용하여 grid search, random search, 수작업 조정을 결합하여 설정된다. 그 다음 계산 제약 때문에 더 큰 모델에서 하이퍼파라미터는 휴리스틱으로 조정했다. 학습 가능한 온도 파라미터 는 Wu et al(2018)을 따라 0.07로 초기화 되고, 학습 불안정성을 방지하기 위해 logit이 100 이상이 되지 않도록 clipped 된다. 우리는 매우 큰 minibatch 크기인 32,768를 사용하고 학습을 가속화하고 메모리를 절약하기 위해 Mixed-precision을 사용한다. 추가적인 메모리 절약을 위해 gradient check-pointing, half-precision Adam statistics와 half-precision 확률적으로 반올림된 text encoder 가중치를 사용한다. embedding 유사성의 계산은 개별 GPU가 local batch의 embedding에 필요한 일부 쌍별 유사도만 계산하도록 분할 된다. 가장 큰 ResNet 모델인 RN50x64는 592개의 V100 GPU에서 18일 동안 학습한 반면 가장 큰 Vision Transformer는 256개의 V100 GPU에서 12일 동안 학습했다. ViT-L/14의 경우 성능을 향상시키기 위해 FixRes와 유사하게 336 픽셀 해상도에서 1 epoch 추가로 pre-train 했다. 우리는 이 모델을 ViT-L/14@336px라고 표기한다. 달리 명시하지 않는한 이 논문에서 ‘CLIP’으로 리포트된 모든 결과는 가장 성능이 좋은 이 모델을 사용한 것이다.

3. Experiments

3.1. Zero-Shot Transfer

3.1.1. MOTIVATION

computer vision에서 zero-shot learning은 대개 이미지 분류에서 본 적 없는 object 카테고리에 대한 일반화의 연구를 의미한다. 그러나 우리는 이 용어를 더 넓은 의미로 사용하여 본 적 없는 데이터셋에 대한 일반화를 연구한다. 이것은 Larochelle et al(2008)의 zero-data learning 논문에서 지향한 것처럼, 본 적 없는 task를 수행하는 proxy로 동기부여 된다. unsupervised learning의 분야에서 많은 연구가 머신러닝 시스템의 representation learning 능력에 초점을 맞추는 반면, 우리는 머신러닝 시스템의 task-learning 능력을 측정하는 방법으로 zero-shot transfer를 연구한다. 이 관점에서 데이터셋은 특정한 분포에 대한 task의 수행을 평가한다. 그러나 대중적인 많은 computer vision 데이터셋은 특정 task에 대한 성능을 측정하는 대신 일반적인 이미지 분류 방법의 개발을 가이드하는 벤치마크로서 주로 연구 커뮤니티에 의해 주로 생성되었다. SVHN 데이터셋이 Google Street View 사진의 분포에 대한 street number transcription의 task를 측정한다고 말하는 것은 합리적이지만, CIFAR-10 데이터셋이 어떤 ‘real’ task를 측정하는지는 불분명하다. 그러나 CIFAR-10 분포가 어떤 분포(TinyImages)에서 추출되었는지는 분명하다. 이런 종류의 데이터셋에서 zero-shot transfer는 task 일반화보다는 CLIP의 분포 이동과 도메인 일반화에 대한 견고성을 평가하는 것에 가깝다. 이 관점에 대한 분석은 섹션 3.3 참조

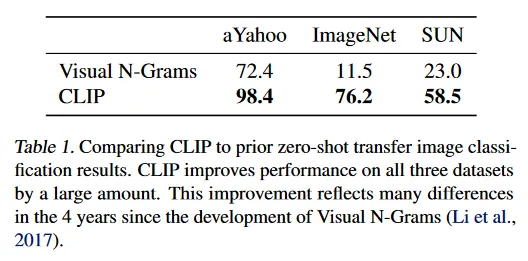

우리가 아는 한 Visual N-Grams가 위에서 설명된 방법으로 기존 이미지 분류 데이터셋에 대한 첫 번째로 연구된 zero-shot transfer이다. 이것은 또한 일반적으로 pre-trained 모델을 사용하여 표준 이미지 분류 데이터셋에 대한 zero-shot transfer를 연구한 유일한 다른 연구이며, CLIP을 contextualizing 하는데 최고의 참조 포인트를 제공한다. 그들의 접근은 142,806개의 visual n-gram(1에서 5 gram까지 포괄)으로 구성된 사전의 파라미터를 학습하고, 주어진 이미지에 대한 모든 텍스트 n-gram의 확률을 최대화하도록 Jelinek-Mercer smoothing의 미분 가능한 버전을 사용하여 이러한 n-gram을 최적화 한다. zero-shot transfer를 수행하는 측면에서 그들은 우선 데이터셋 각 클래스 이름의 텍스트를 n-gram representation으로 변환한 다음 모델에 따라 그 확률을 계산하여 가장 높은 점수를 갖는 것을 예측한다.

task 학습의 평가로써 zero-shot transfer를 연구하는 우리의 초점은 NLP 영역에서 task 학습을 시연하는 연구에 영감 받았다. 우리가 아는 한 Liu et al(2018)가 처음으로 task learning을 ‘unexpected side-effect’로써 식별했는데, 이는 위키피디아 글을 생성하도록 학습된 언어 모델이 언어 간 이름을 안정적으로 음역하는 법을 배웠을 때였다. GPT-1은 supervised fine-tuning을 개선하기 위해 transfer learning 방법으로 pre-training에 초점을 맞춘 반면, 4가지 휴리스틱 zero-shot transfer 방법의 성능이 supervised 적용 없이 pre-training 과정에서 꾸준히 개선되는 것을 보이는 ablation 연구도 포함했다. 이 분석은 zero-shot transfer를 통해 언어 모델의 task-learning 능력을 연구하는 것에 전적으로 초점을 맞춘 GPT-2에 대한 기저를 제공한다.

3.1.2. USING CLIP FOR ZERO-SHOT TRANSFER

CLIP은 데이터셋에서 이미지와 텍스트 snippet이 쌍을 이루는지 예측하도록 pre-trained이다. zero-shot 분류를 수행하기 위해 우리는 이 능력을 재사용한다. 각 데이터셋에 대해 우리는 데이터셋의 모든 클래스의 이름을 잠재적 텍스트 쌍의 집합으로 사용하고 CLIP을 따라 가장 확률 높은 (이미지, 텍스트) 쌍을 예측한다. 좀 더 자세히 설명하면, 우리는 우선 각각의 encoder를 통해 이미지의 feature embedding과 가능한 텍스트의 집합의 feature embedding을 계산하고, 그 다음 이러한 embedding의 cosine 유사도를 계산하고, 온도 파라미터 로 스케일링한 후, softmax를 통해 확률 분포로 normalized한다. 이러한 prediction layer는 L2-normalized 입력, L2-normalized 가중치, bias 없음과 temperature scaling을 가진 multinomial logistic regression 분류기이다. 이 방법으로 해석될 때, 이미지 encoder는 이미지의 feature representation을 계산하는 computer vision backbone이고, 텍스트 encoder는 클래스가 나타내는 시각 컨셉을 지정하는 텍스트를 기반으로 선형 분류기의 가중치를 생성하는 hyper-network이다. Lei Ba et al(2015)는 이러한 형식의 zero-shot image 분류기를 도입한 첫 번째이다. 자연어에서 분류기를 생성하는 아이디어는 적어도 Elhoseiny et al(2013)까지 거슬러 올라간다. 이러한 해석을 계속하면 CLIP pre-training의 각 step은 자연어 description을 통해 정의된 총 32,769 클래스와 클래스 당 1개 예제를 포함하는 무작위로 생성된 computer vision 데이터셋의 proxy의 성능을 최적화하는 것으로 볼 수 있다. zero-shot 평가를 위해 우리는 텍스트 encoder에 의해 계산된 zero-shot 분류기를 캐싱하고 이후 모든 예측에 재사용한다. 이를 통해 생성 비용을 데이터셋에서 모든 예측에 걸쳐 armotized 할 수 있다.

3.1.3. INITIAL COMPARISON TO VISUAL N-GRAMS

Table 1에서 우리는 Visual N-Gram을 CLIP과 비교한다. 최고의 CLIP 모델은 ImageNet에서 정확도를 PoC 11.5%에서 76.2%까지 개선하며, 이 데이터셋을 위해 1.28M crowd-라벨링 학습 예제를 사용하지 않았음에도 원래의 ResNet-50의 성능과 일치한다. 또한 CLIP 모델의 top-5 정확도는 그들의 top-1 보다도 주목할만큼 높다. 그리고 이 모델은 Inception-V4와 일치하는 95% top-5 정확도를 갖는다. zero-shot 설정에서 강력한 fully supervised baseline 성능과 일치하는 능력은 CLIP이 유연하고 실용적인 zero-shot computer vision 분류기를 향한 중요한 진전임을 시사한다. 위에서 언급한 것처럼 Visual N-Gram에 대한 비교는 CLIP의 성능을 contextualizing 하기 위한 것이며, 두 시스템 사이의 성능과 관련된 많은 차이가 통제되지 않았기 때문에 CLIP과 Visual N-Gram 사이의 직접적인 방법 비교로써 해석되서는 안된다. 예컨대 우리는 10배 더 큰 데이터셋에서 학습했다. 예측당 거의 100배 더 많은 계산을 요구하는 vision 모델을 사용하며, 약 1000배 이상 학습 계산을 사용했고, Visual N-Gram이 공개되었을 때 존재하지 않았던 transformer 기반 모델을 사용한다. 더 가까운 비교로서 우리는 Visual N-Gram이 학습했던 동일한 YFCC100M 데이터셋에서 CLIP ResNet-50을 학습하고 V100 GPU 하루 만에 그들이 보고한 ImageNet 성능과 일치하는 것을 발견했다. 이러한 baseline은 또한 Visual N-Gram에서와 같이 pre-trained ImageNet 가중치에서 초기화되지 않고 처음부터 학습되었다.

CLIP은 리포트된 다른 2개 데이터셋에서도 Visual N-Gram을 능가한다. Yahoo에서 CLIP은 에러의 수를 95% 축소 시키고, SUN에서 Visual N-Gram의 정확도 보다 두 배 높다. 더 포괄적인 분석과 스트레스 테스트를 구성하기 위해 우리는 부록 A에서 상세히 설명된 훨씬 더 큰 평가 suite를 구현한다. 전체적으로 우리는 Visual N-Gram에서 리포트된 3개 데이터셋에서 30개 이상의 데이터셋으로 확장하고 결과를 contextualize 하기 위해 50개 이상의 기존 computer vision 시스템과 비교했다.

3.1.4. PROMPT ENGINEERING AND ENSEMBLING

대부분 표준 이미지 분류 데이터셋은 자연어 기반 zero-shot transfer를 가능하게 하는 클래스를 명명하거나 설명하는 정보를 후속 고려사항으로 취급한다. 대부분의 데이터셋은 이미지에 단순히 라벨의 숫자 ID만 주석을 달고, 이 ID를 영어 이름으로 다시 매핑하는 파일을 포함한다. Flowers102와 GTSRB 같은 일부 데이터셋은 공개된 버전에 이 매핑을 전혀 포함하지 않아 zero-shot transfer를 완전히 불가능하게 한다. 많은 데이터셋에서 우리는 이러한 라벨이 무작위로 선택되었으며 task description에 의존하는 zero-shot transfer와 관련하여 이슈를 예상하지 못했음을 관찰했다.

일반적인 이슈는 polysemy(다의성)이다. 클래스의 이름이 CLIP의 텍스트 encoder에 제공되는 유일한 정보일 때 context의 부족 때문에 어떤 단어 의미가 의도 되었는지 구별 가능하지 않다. 동일한 단어가 여러 의미를 갖는 경우에 동일한 데이터셋에서 서로 다른 클래스에 포함될 수 있다. 이것은 ImageNet에서 발생하는데, 건설용 cranes와 날아다니는 cranes이 모두 포함된다. 또 다른 예제는 Oxford-IIIT Pet 데이터셋의 클래스에서 발견된다. 여기서 ‘boxer’라는 단어는 맥락 상 분명히 dog의 품종을 의미하지만 맥락이 부족한 텍스트 encoder에서 운동선수의 유형으로 참조될 수 있다.

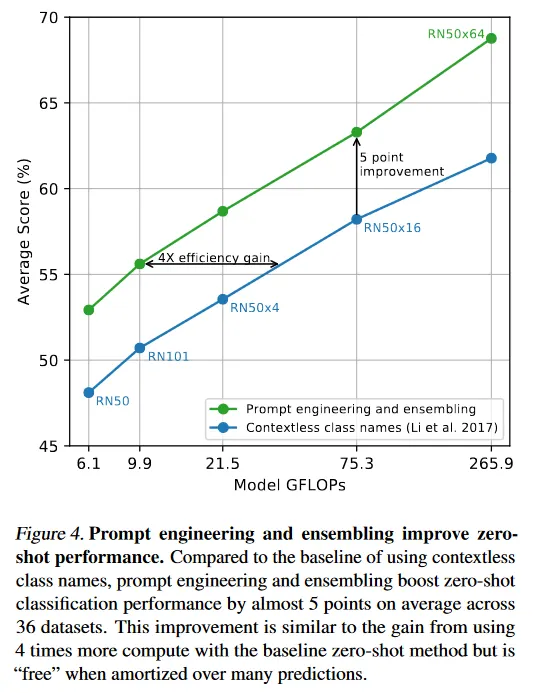

우리가 마주한 또 다른 이슈는 pre-training 데이터셋에서 이미지와 쌍을 이루는 텍스트가 단일 단어인 경우가 상대적으로 드물다는 것이다. 일반적으로 텍스트는 이미지를 어떤 방식으로든 설명하는 완전한 문장이다. 이러한 분포 격차의 다리를 놓기 위해, 우리는 ‘A photo of a {label}’라는 프롬프트 템플릿을 사용하는 것이 텍스트가 이미지의 컨텐츠에 관한 것임을 지정하는데 도움이 되는 좋은 default라는 것을 발견한다. 이것은 종종 라벨링 텍스트만 사용하는 baseline에 대해 성능을 개선한다. 예컨대 이 프롬프트를 사용하는 것만으로도 ImageNet에서 정확도를 1.3% 개선한다.

GPT-3에 대한 ‘prompt engineering’ 논의와 유사하게, 우리는 각 task에 대한 prompt text를 커스터마이징하여 zero-shot 성능을 상당히 개선할 수 있다는 것을 관찰한다. 소수의, 철저하지 않은 예제는 다음과 같다. 우리는 여러 fine-grained 이미지 분류 데이터셋에서 카테고리를 지정하는 것이 도움이 된다는 것을 발견한다. 예컨대 Oxford-IIIT Pets에 서 ‘A photo of a {label}, a type of pet.’ 을 사용하여 맥락을 제공하는 것이 잘 작동했다. 유사하게 Food101에서 음식의 유형, FGVC Aircraft에서 항공기 유형을 지정하는 것이 도움이 된다. OCR 데이터셋의 경우 인식을 텍스트나 숫자를 인용으로 넣는 것이 성능을 개선한다. 마지막으로 우리는 위성 이미지 분류 데이터셋에서 이미지가 이러한 형태임을 지정하는 것이 도움이 되며, ‘a satellite photo of a {label}’의 변형을 사용했다.

우리는 또한 성능을 개선하는 또 다른 방법으로 multiple zero-shot 분류기에 대한 앙상블을 실험했다. 이러한 분류기는 ‘A photo of a big {label}’과 ‘A photo of a small {label}’과 같은 다양한 context prompt를 사용하여 계산된다. 우리는 확률 공간 대신 embedding 공간에 대해 앙상블을 구성한다. 이를 통해 평균화된 텍스트 embedding의 단일 집합을 캐시할 수 있어 많은 예측에 대해 amortized일 때 앙상블의 계산 비용이 단일 분류기를 사용하는 것과 동일해진다. 우리는 많은 생성된 zero-shot 분류기에 걸쳐 앙상블링하는 것이 성능을 믿을만하게 개선하는 것을 관찰하고 대부분의 데이터셋에서 이를 사용한다. ImageNet에서 우리는 80개 다양한 context prompt를 앙상블하면 위에서 논의한 단일 default prompt 보다 성능을 추가로 3.5% 개선한다. prompt engineering과 앙상블을 함께 고려할 때, ImageNet 정확도는 거의 5% 개선된다.

그림 4는 prompt engineering과 앙상블이 Li et al(2017)에서 수행한 것처럼 클래스 이름을 직접 embedding하는 맥락 없는 baseline 접근과 비교하여 CLIP 모델의 집합의 성능을 어떻게 변화시키는지 보인다.

3.1.5. ANALYSIS OF ZERO-SHOT CLIP PERFORMANCE

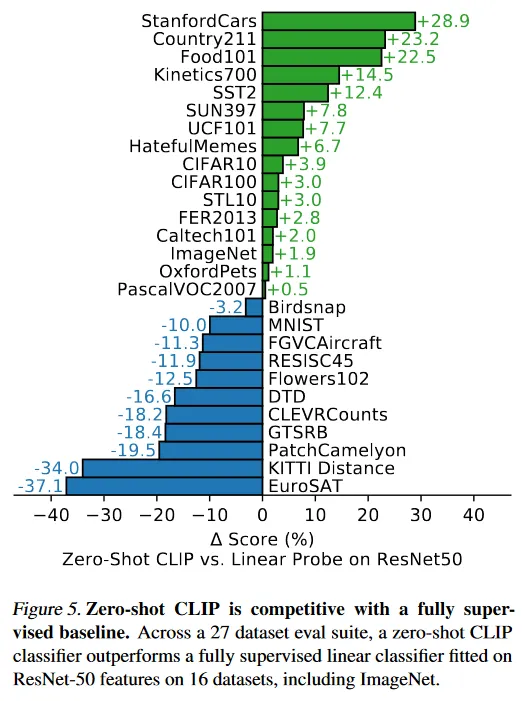

computer vision을 위한 task-agnostic zero-shot 분류기가 덜 연구되었기 때문에 CLIP은 이러한 유형의 모델을 더 잘 이해할 수 있는 유망한 기회를 제공한다. 이 섹션에서 우리는 CLIP의 zero-shot 분류기의 다양한 속성의 연구를 구성한다. 첫 번째 질문으로 우리는 단순히 zero-shot 분류기가 얼마나 잘 수행되는지 본다. 이것을 맥락화하기 위해 우리는 표준 ResNet-50의 feature에 대한 fully supervised, regularized, logistic regression 분류기인 간단한 off-the-shelf baseline의 성능과 비교한다. 그림 5에서 우리는 27개 데이터셋에 대해 이러한 비교를 보인다. 데이터셋과 설정에 대한 상세는 부록 A 참조.

zero-shot CLIP이 이 baseline 보다 약간 더 자주 능가하며 27개 중 16개 데이터셋에서 이긴다. 각 데이터셋을 살피면 몇 가지 흥미로운 동작이 드러난다. fine-grained 분류 task에서 우리는 성능의 넓은 spread를 관찰한다. 이러한 데이터셋의 2개인 Stanford Cars와 Food101에서 zero-shot CLIP은 ResNet-50 feature에 대한 logistic regression을 20% 이상 능가하는 반면 다른 두 개인 Flowers102와 FGVCAircraft에서는 zero-shot CLIP은 10% 떨어진다. OxfordPets와 Birdsnap에서는 성능은 훨씬 비슷하다. 우리는 이러한 차이가 주로 WIT와 ImageNet 사이의 task 당 supervision의 양이 다르기 때문이라고 추측한다. ImageNet, CIFAR10/100, STL10과 PascalVOC2007과 같은 ‘일반적인’ object 분류 데이터셋에서 성능은 상대적으로 유사하며 모든 경우에서 zero-shot CLIP이 약간 우위이다. STL10에서 CLIP은 임의의 학습 예제 없이도 전체 99.3%를 달성하여 최첨단을 보인다. zero-shot CLIP은 비디오에서 action recognition하는 두 데이터셋에서 ResNet-50을 상당히 능가한다. Kinetics700에서 CLIP은 ResNet-50을 14.5% 능가하고, zero-shot CLIP은 또한 UCF101에서 ResNet-50의 feature를 7.7% 능가한다. 우리는 이것이 ImageNet에서 명사-중심 object supervision과 비교하여 자연어가 동사를 포함하는 시각 컨셉에 대해 더 넓은 supervision을 제공하기 때문이라고 추측한다.

zero-shot CLIP은 주목할만하게 뒤쳐지는 부분을 보면 위성 이미지 분류(EuroSAT, RESISC45), 림프 노드 종양 감지(PatchCamelyon), 합성 장면에서 객체 counting(CLEVRCounts), 독일 교통 사인 인식(GTSRB), 가장 가까운 차와 거리 인식(KITTI Distance) 같은 자율 주행 관련 task와 같은 복잡하거나 추상적 task에서 CLIP이 매우 약하다는 것을 알 수 있다. 이러한 결과는 더 복잡한 task에 대한 zero-shot CLIP의 빈곤한 능력을 강조한다. 반면에 비전문가 인간은 counting, 위성 이미지 분류와 교통 사인 인식과 같은 여러 task에서 견고하게 수행할 수 있어서 상당한 개선의 여지가 있음을 시사한다. 그러나 림프 노드 종양 분류 같은 거의 모든 인간(그리고 아마도 CLIP)에게 prior 경험이 없는 어려운 task에 대해 zero-shot transfer 대신 few-shot transfer를 측정하는 것이 의미있는 평가인지 여부가 불분명하다는 점에 주의해야 한다.

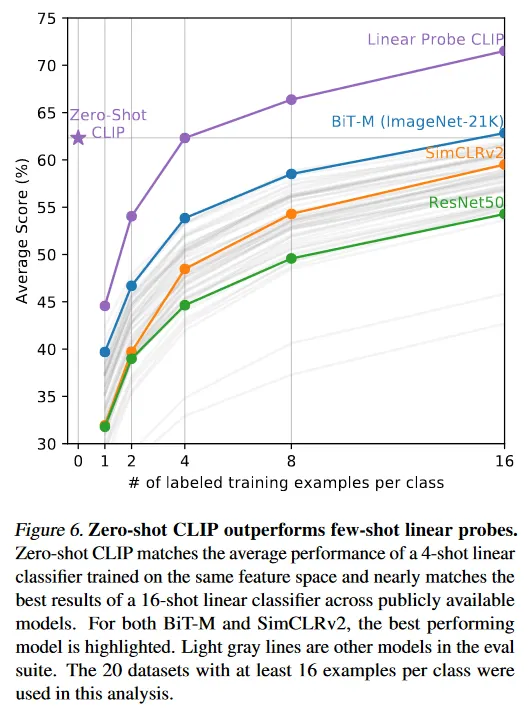

zero-shot 성능을 fully supervised model과 비교하는 것이 CLIP의 task-학습 능력을 맥락화하지만, zero-shot이 한계이므로 few-shot 방법과 비교하는 것이 더 직접적인 비교이다. 그림 6에서 zero-shot CLIP이 공개적으로 접근 가능한 최고의 ImageNet 모델, self-supervised learning 방법과 CLIP 자체를 포함한 많은 이미지 모델의 feature에 대한 few-shot logistic regression과 비교한다. 직관적으로 zero-shot이 one-shot에 뒤쳐질 것이라고 예상되지만, 우리는 오히려 zero-shot CLIP이 동일한 feature 공간에서 4-shot logistic regression의 성능과 일치함을 발견한다. 이것은 zero-shot과 few-shot 접근 사이의 중요한 차이 때문일 수 있다. 우선 CLIP의 zero-shot 분류기는 자연어를 통해 생성되어 시각적 컨셉을 직접 명시(’communicated’) 할 수 있다. 반면 ‘normal’ supervised learning은 학습 예제에서 간접적으로 개념을 추론해야 한다. 맥락없는 예제 기반 학습은 특히 one-shot 경우에 서로 다른 가설이 데이터와 일치할 수 있다는 단점을 갖는다. 단일 이미지는 종종 다양한 시각적 개념을 포함할 수 있다. 능력 있는 학습자는 시각적 단서와 휴리스틱을 활용할 수 있지만, 예컨대 이미지에서 시연된 개념이 주요 객체라고 가정하는 경우도 있지만 이것을 보장할 수 없다.

zero-shot과 few-shot 성능 사이의 이러한 불일치를 해결할 수 있는 잠재적 방법은 CLIP의 zero-shot 분류기를 few-shot 분류기의 가중치에 대한 prior로써 사용하는 것이다. L2 페널티를 가중치에 추가하는 것은 이 아이디어의 간단한 구현이지만, 하이퍼파라미터 최적화하면 이 regularizer의 값이 너무 커져 결과적으로 few-shot 분류기가 그냥 zero-shot 분류기가 되는 경우가 많았다. zero-shot transfer의 강점을 few-shot learning의 유연성과 결합하는 더 나은 방법에 대한 연구는 미래의 유망한 방향이다.

다른 모델의 feature에 대해 zero-shot CLIP을 few-shot logistic regression과 비교할 때 zero-shot CLIP은 우리가 평가한 것들 중 최고 성능 16-shot 분류기의 성능과 대략 일치한다. 이것은 BiT-M Resnet-152x2의 feature를 사용하고 ImageNet-21K에서 학습된다. JFT-300M에서 학습된 BiT-L 모델이 더 좋을 것이라 확신하지만 이 모델이 공개적으로 배포 되지 않는다. 16-shot 설정에서 BiT-M ResNet-152x2가 가장 좋은 성능을 보인 것은 놀라운 결과이다. 섹션 3.2에서 분석한대로 Noisy Student EfficientNet-L2는 fully supervised 설정에서 27개 데이터셋에 걸쳐 평균적으로 거의 5% 능가하기 때문이다.

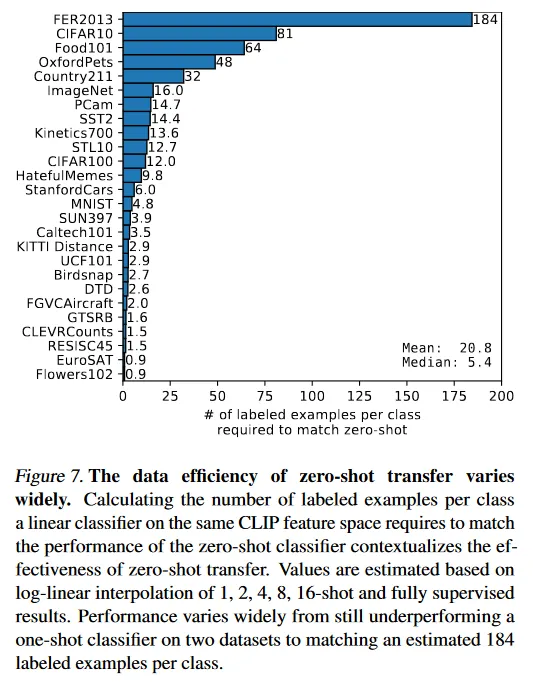

zero-shot CLIP과 few-shot logistic regression의 평균 성능을 연구하는 것 외에도, 우리는 각 데이터셋에서 성능도 실험한다. 그림 7에서 동일한 feature 공간에서 logistic regression 분류기가 zero-shot CLIP의 성능과 일치하기 위해 클래스 당 필요한 라벨링된 예제의 수를 추정한 결과를 보인다. zero-shot CLIP도 선형 분류기이므로 이 추정은 이 설정에서 zero-shot transfer의 실질적인 데이터 효율성을 추정한 것이다. 수천 개의 선형 분류기를 학습하는 것을 피하기 위해, 우리는 각 데이터셋에서 1, 2, 4, 8, 16-shot(가능할 때)과 fully supervised linear 분류기의 성능을 log-linear 보간을 통해 데이터 효율성을 추정한다. 우리는 zero-shot transfer가 데이터셋 별로 크게 다른 효율성을 가짐을 발견한다. 클래스 당 1개 미만의 라벨링된 예제에서 184까지 차이가 있었다. 두 개의 데이터셋 Flowers102와 EuroSAT은 one-shot 모델에 뒤쳐진다. 데이터셋의 절반은 클래스당 5개 미만의 예제가 필요하고 median은 5.4이다. 그러나 평균 추정된 데이터 효율성은 클래스당 20.8 예제이다. 이것은 전체 데이터셋 중 20%가 성능을 일치하기 위해 supervised 분류기가 클래스당 많은 라벨링된 예제를 필요하기 때문이다. ImageNet에서 zero-shot CLIP이 동일한 feature 공간에서 학습된 16-shot linear 분류기의 성능과 일치한다.

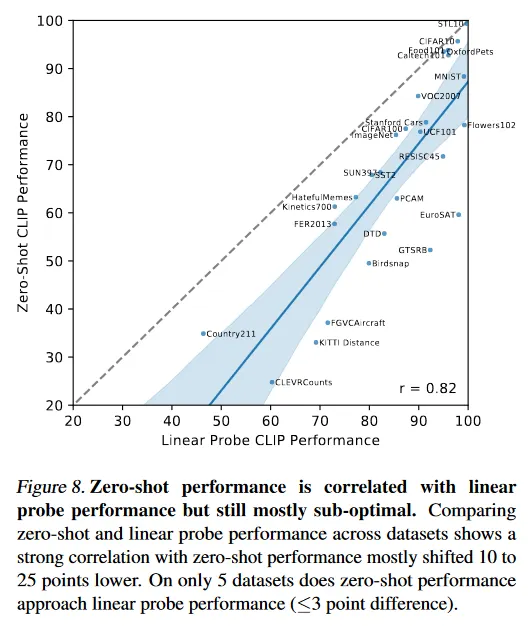

우리는 평가 데이터셋이 커서 그것에서 학습된 선형 분류기의 파라미터가 잘 추정된다고 가정하면 CLIP의 zero-shot 분류기가 또한 선형 분류기이므로 fully supervised 분류기의 성능은 zero-shot transfer가 달성할 수 있는 것에 대한 상한을 대략 설정한다. 그림 8에서 CLIP의 zero-shot 성능을 fully supervised linear 분류기와 데이터셋에 걸쳐 비교한다. 점선 은 동등한 fully supervised의 성능과 일치하는 ‘최적’ zero-shot 분류기를 나타낸다. 대부분의 데이터셋에서 zero-shot 분류기의 성능은 여전히 fully supervised 분류기보다 10%-25% 뒤쳐진다. CLIP의 task-learning과 zero-shot transfer 능력을 개선할 여지가 많다는 것을 시사한다.

zero-shot 성능과 fully supervised 성능 사이에 0.82(p-value < )의 양의 상관관계가 있으며, 이것은 CLIP이 기본 representation과 task learning을 zero-shot transfer에 연결하는 데 있어 비교적 일관성 있음을 시사한다. 그러나 zero-shot CLIP은 5개 데이터셋에서만 fully supervised 성능에 접근한다. STL10, CIVAR10, Food101, OxfordPets, Caltech101. 5개 데이터셋 모두 zero-shot 정확도와 fully supervised 정확도는 90%를 넘는다. 이것은 CLIP이 기본 representation이 고품질인 task에서 zero-shot transfer에 더 효율적일 수 있음을 시사한다. fully supervised 성능을 기준으로 zero-shot 성능을 예측하는 linear regression 모델의 기울기는 fully supervised 성능이 1% 개선 될 때 zero-shot 성능이 1.28% 개선된다고 추정한다. 그러나 95th 백분위수 신뢰도 구간은 여전히 1 미만의 값(0.93-1.79)을 포함한다.

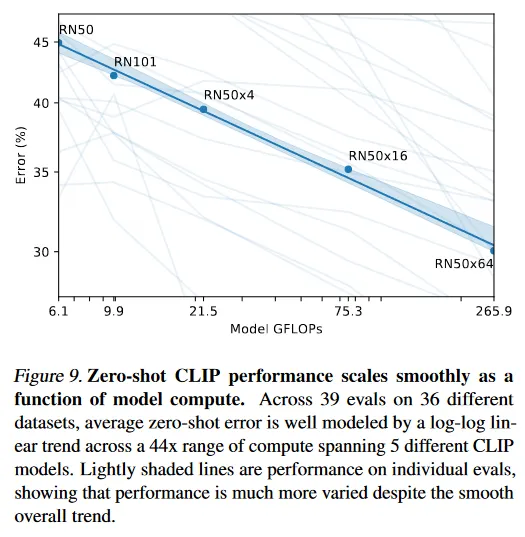

지난 몇 년간 딥 러닝 시스템의 실험적 연구는 성능이 학습 계산과 데이터 크기의 중요한 분위수의 함수로써 예측가능하다는 것을 문서화 했다. GPT 계열의 모델은 지금까지 학습 비용이 1000배 증가함에 따라 zero-shot 성능이 일관된게 향상됨을 보였다. 그림 9에서 우리는 CLIP의 zero-shot 성능이 이와 유사한 스케일링 패턴을 따르는지 체크한다. 우리는 36개 다른 데이터셋에서 39번의 평가를 통해 5개의 ResNet CLIP 모델의 평균 에러 비율을 그리고 CLIP에서 모델 계산이 44배 증가함에 따라 유사한 log-log linear 스케일링 경향이 유지됨을 확인한다. 전체적인 경향이 smooth이지만 개별 평가에 대한 성능은 훨씬 noisier하다는 것을 발견한다. 우리는 이것이 sub-task에서 개별 학습 실행 간의 높은 분산이 꾸준히 개선되는 경향을 masking 하는 것인지 아니면 일부 task에서 성능이 실제로 계산의 함수로 단조롭지 않는 것인지 확신할 수 없다.

3.2. Representation Learning

이전 섹션에서 zero-shot transfer를 통해 CLIP의 task-learning 능력을 광범위하게 분석했지만, 모델의 representation learning 능력을 연구하는 것이 더 일반적이다. representation의 품질을 평가하는 방법은 많이 있으며, ‘이상적인’ representation이 가져야 할 속성이 무엇인지에 대한 논란이 있다. 모델에서 추출된 representation에 대해 선형 분류기를 fitting하고 다양한 데이터셋에서 그 성능을 측정하는 것이 일반적인 접근이다. 대안은 모델의 end-to-end fine-tuning 의 성능을 측정하는 것이다. 이것은 유연성을 증가시키고 이전 연구에서 대부분 이미지 분류 데이터셋에서 fine-tuning이 선형 분류기를 능가하는 것을 설득력있게 시연했다. fine-tuning의 높은 성능이 실용적인 이유로 해당 연구를 동기부여하지만 우리는 여러 이유로 여전히 선형 분류기 기반 평가를 고른다. 우리의 연구는 고성능 task과 dataset-agnostic pre-training 접근을 개발하는데 초점을 맞춘다. fine-tuning은 fine-tuning 단계 동안 각 데이터셋에 대해 representation을 적용하기 때문에 pre-training 단계 동안 일반적이고 견고한 representation을 학습하지 못한 것을 보완하고 잠재적으로 masking할 수 있다. 선형 분류기는 제한된 유연성 때문에 이러한 실패를 강조하고 개발하는 동안 명확한 피드백을 제공한다. CLIP에 대해 supervised linear 분류기를 학습하는 것은 zero-shot 분류기에 사용된 매우 접근과 매우 유사하여 섹션 3.1에서 광범위한 비교와 분석이 가능하다는 추가적인 이점이 있다. 마지작으로 우리는 CLIP을 많은 작업에 걸쳐 기존의 포괄적인 모델 집합과 비교하는데 초점을 맞춘다. 27개 다른 데이터셋에 대해 66개의 다른 모델을 연구하려면 1782개 다른 평가를 조정해야 한다. fine-tuning은 훨씬 더 큰 설계와 하이퍼파라미터 공간을 열지만, 이는 다른 대규모 실험에서 논의된 것처럼 다양한 기술 집합을 공정한 평가가 어렵고 계산적으로 비싸다. 이에 비해 선형 분류기는 최소한의 하이퍼파라미터 튜닝만 필요하고 표준화된 구현과 평가 절차를 갖고 있다. 평가에 대한 더 자세한 내용은 부록 A 참조.

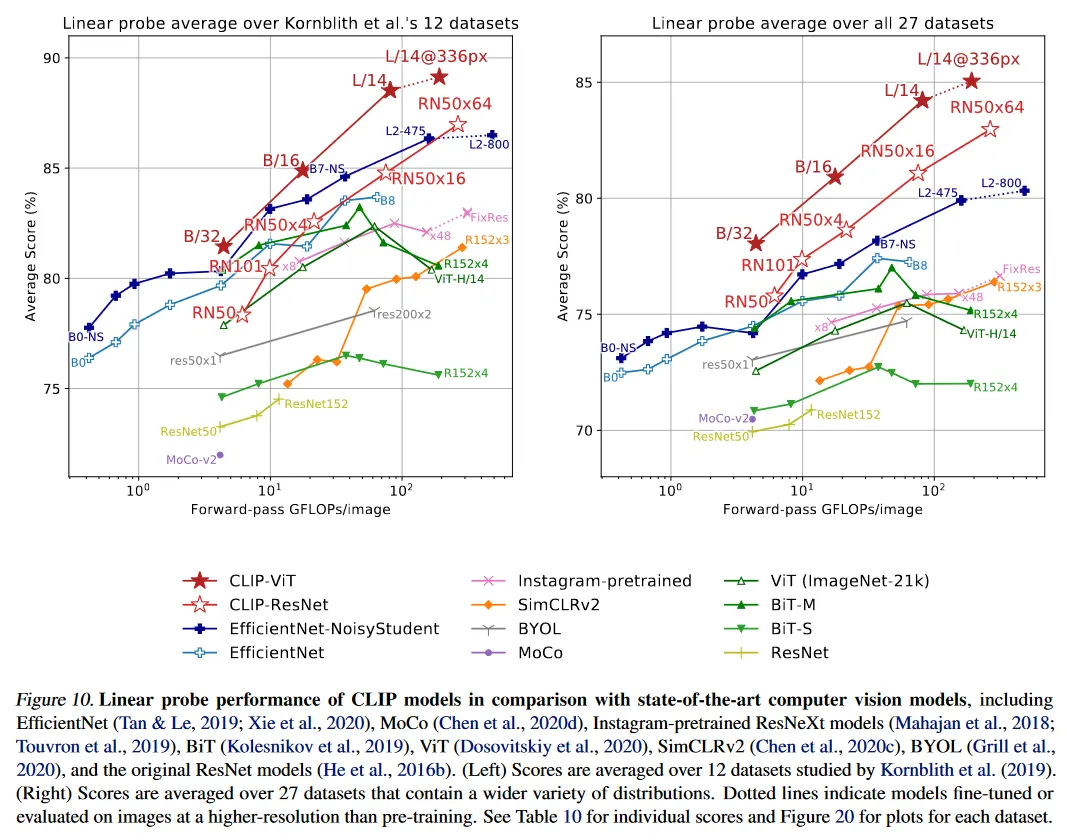

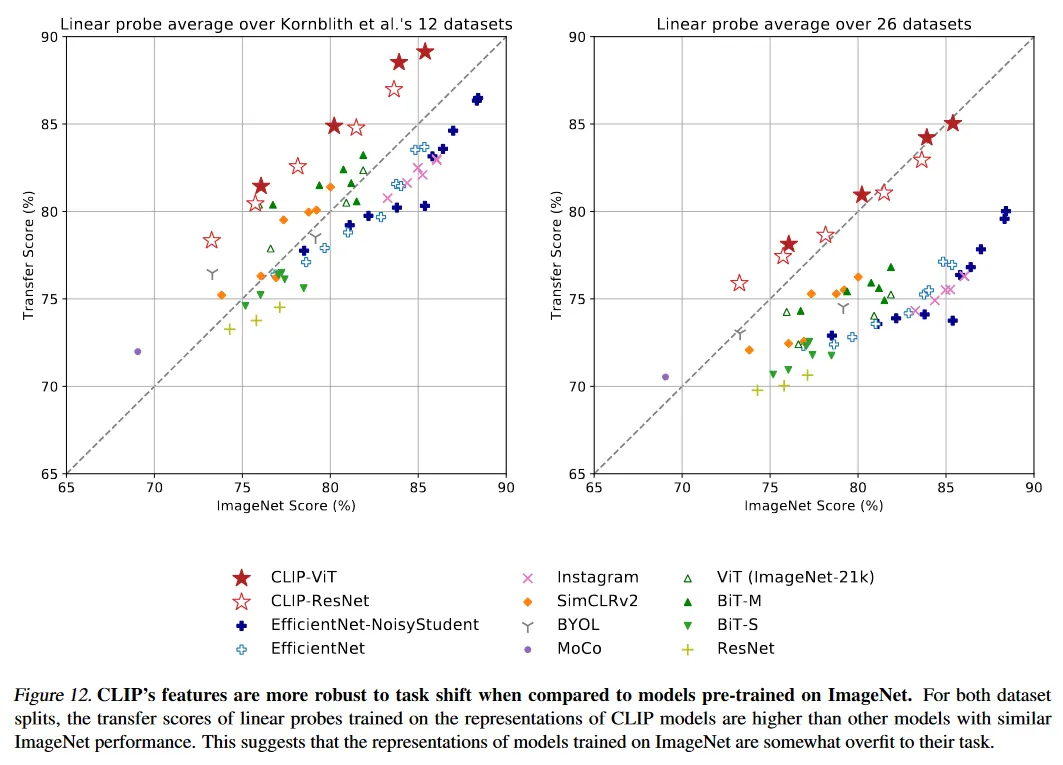

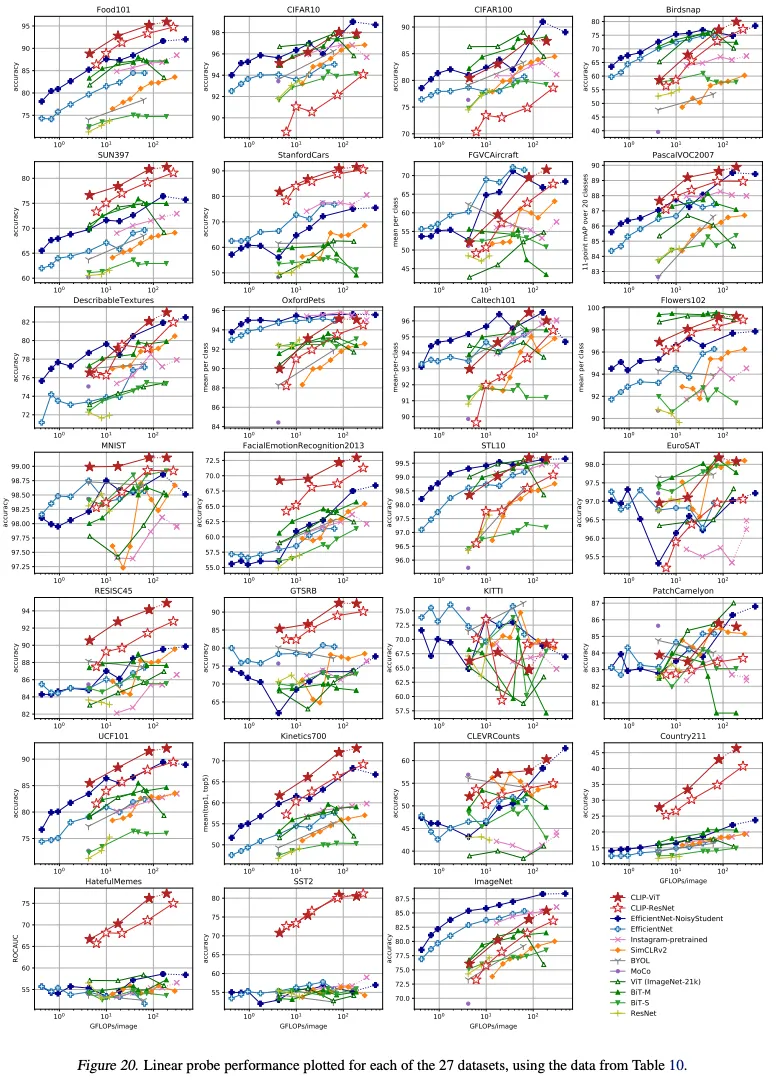

그림 10은 우리의 발견을 요약한다. 확인 또는 보고 bias에 대한 우려가 드러날 수 있는 선택 효과를 최소화하기 위해, 우리는 우선 Kornblith et al(2019)의 12개 데이터셋 평가 suit에서 연구를 수행한다. ResNet-50과 ResNet-101과 같은 작은 CLIP 모델이 ImageNet-1K에서 학습된 다른 ResNet(BiT-S와 오리지날)을 능가하지만 ImageNet-21K(BiT-M)에서 학습된 ResNet에 뒤쳐진다. 이러한 작은 CLIP 모델은 또한 유사한 계산 요구량을 갖는 EfficientNet 모델 계열에 뒤쳐진다. 그러나 CLIP으로 학습된 모델은 매우 잘 확장되고 우리가 학습시킨 가장 큰 모델(ResNet-50x64)는 기존의 최고 성능 모델(Noisy Student EfficientNet-L2)을 전체 score와 계산 효율성 모두에서 약간 능가한다. 우리는 또한 CLIP vision transformer가 CLIP ResNet보다 약 3배 계산 효율적임을 발견한다. 이것은 계산 예산에서 훨씬 높은 성능에 도달하게 한다. 이러한 결과는 충분히 큰 데이터셋에서 학습될 때 vision transformer가 convnet 보다 훨씬 더 계산 효율적이라고 리포트한 Dosovitskiy et al(2020)의 발견을 정성적으로 제현한 것이다. 우리의 전반적인 최고 모델은 ViT-L/14로 데이터셋에서 336 픽셀의 고해상도에서 1 epoch 추가 fine-tune 된다. 이 모델은 이 평가 방식에서 기존 최고 모델을 평균적으로 2.6% 능가한다.

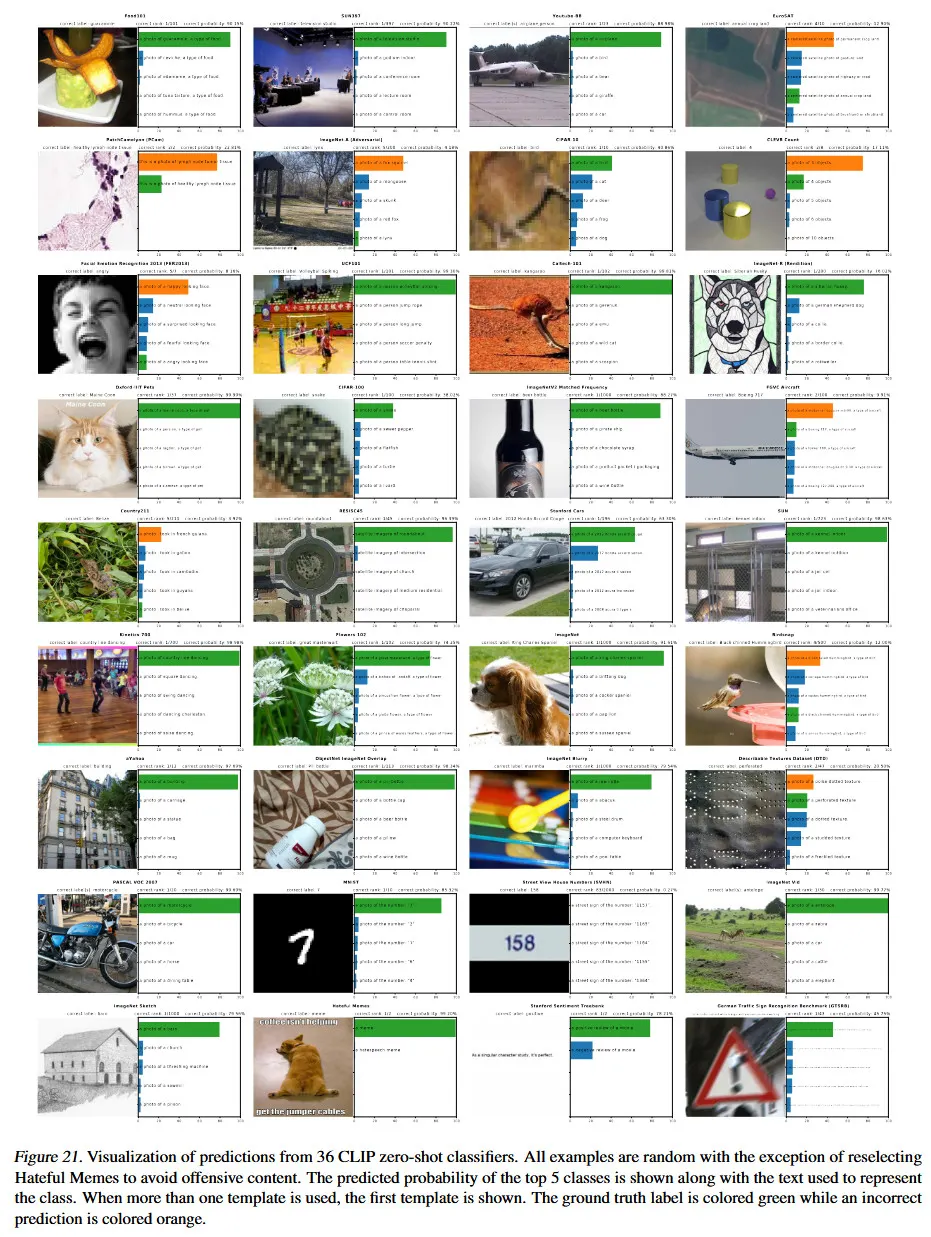

그림 21에서 정성적으로 보이는 것처럼 CLIP 모델은 이전에 랜덤 초기화에서 end-to-end로 학습된 단일 computer vision 모델에서 시연된 것보다 더 넓은 task 집합을 학습한다. 이러한 task에는 geo-localization, optical character recognition, facial emotion recognition과 action recognition이 포함된다. 이러한 task 중 어느 것도 Kornblith et al(2019)의 평가 집합에서 평가되지 않았다. 이것은 Kornblith et al(2019)의 연구가 ImageNet과 겹치는 task에서 선택 편향이라는 논란의 근거가 될 수 있다. 이것을 해결하기 위해 우리는 더 넓은 27개 데이터셋 평가 집합에서 성능을 평가한다. 부록 A에서 더 상세히 설명되는 이 평가 집합에는 앞서 언급한 task를 대표하는 데이터셋들, 독일 교통 사인 인식 벤치마크와 VTAB에서 채택된 여러 다른 데이터셋들을 포함된다.

이 더 넓은 평가 방식에서 CLIP의 이점은 더 분명하다. 모든 CLIP 모델은 스케일에 관계없이 계산 효율성 측면에서 모든 평가된 시스템을 능가한다. 최고 모델의 평균 score가 이전 시스템에 대해 2.6%에서 5% 증가된다. 우리는 또한 self-supervised 시스템이 우리의 더 넓은 평가 방식에서 눈에 띄게 더 낫다는 것을 발견한다. 예컨대 SimCLRv2는 Kornblith et al(2019)의 12개 데이터셋에서 여전히 평균적으로 BiT-M에 뒤쳐지지만, 우리의 27개 데이터셋 모음에서는 BiT-M을 능가한다. 이러한 발견은 시스템의 ‘일반적인’ 성능을 더 잘 이해하기 위해 task 다양성과 범위를 계속 확장해야 한다는 것을 시사한다. 우리는 VTAB과 같은 추가적인 평가 노력이 가치있을 것이라고 추측한다.

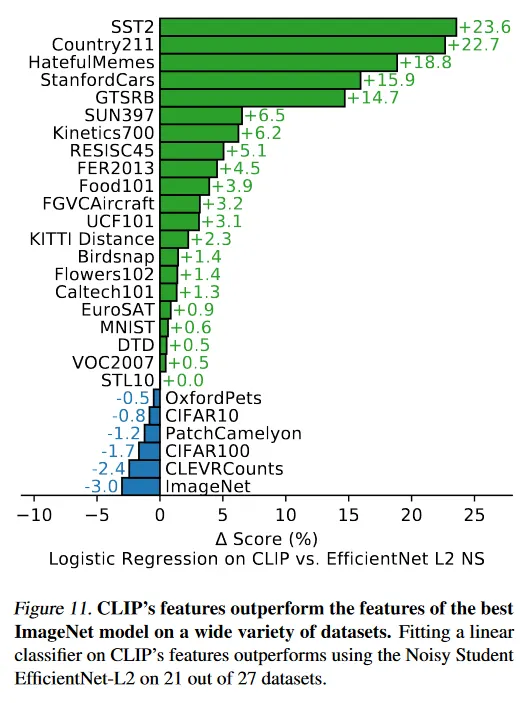

위의 종합적인 분석에 더해 우리는 그림 11에서 27개 데이터셋에 걸쳐 최고 CLIP 모델과 우리 평가 방식에서 최고의 모델간 데이터셋 성능 차이를 시각화 한다. CLIP은 27개 데이터셋에서 21개에서 Noisy Student EfficientNet-L2를 능가한다. CLIP은 OCR이 필요한 작업(SST2와 HatefulMemes), geo-localization과 scene recognition(Contry211, SUN397)과 비디오에서 activity recognition(Kinetics700과 UCF101)에서 가장 크게 개선한다. 또한 CLIP은 fine-grained car와 traffic sign recognition(Stanford Cars and GTSRB)에서도 훨씬 낫다. 이것은 ImageNet의 지나치게 좁은 supervision에 문제가 있음을 반영할 수 있다. GTSRB에서 14.7% 개선과 같은 결과는 모든 교통과 거리 사인에 대해 단일 라벨만 갖는 ImageNet-1K의 이슈를 나타낼 수 있다. 이것은 supervised representation이 intra-class 디테일을 붕괴시키고 fine-grained downstream task의 정확도에 해를 끼칠 수 있도록 조장할 수 있다. 언급했듯이 CLIP은 여러 데이터셋에서 여전히 EfficientNet에 뒤쳐진다. 놀랍지 않게도 EfficientNet이 CLIP에 비해 가장 좋은 성능을 보이는 데이터셋은 바로 그것이 학습된 ImageNet이다. EfficientNet은 또한 CIFAR10과 CIFAR100 같은 저해상도 데이터셋에서 CLIP을 약간 능가한다. 우리는 이것이 적어도 부분적으로 CLIP에서 scale 기반 데이터 증강이 부족하기 때문일 것이라고 추측한다. EfficientNet은 또한 PatchCamelyon과 CLEVRCount에서 약간 나은데, 이 데이터셋에서는 두 접근 방식 모두 전반적인 성능이 여전히 낮다.

3.3. Robustness to Natural Distribution Shift

2015년 한 딥러닝 모델이 ImageNet test set에서 인간 성능을 추월했다고 발표되었다. 그러나 이후 몇 년간의 연구는 이러한 모델들이 여전히 많은 단순한 실수를 저지른다는 것이 반복적으로 밝혀졌다. 또한 이러한 시스템들을 테스트하는 새로운 벤치마크는 종종 그들의 성능이 ImageNet 정확도와 인간 정확도 모두에 비해 훨씬 낮다는 것을 발견했다. 이 불일치가 어떻게 설명될 수 있는가? 다양한 아이디어가 제안되었고 연구되었다. 제안된 설명의 공통된 주제는 딥러닝 모델들이 학습 데이터셋 전체 걸쳐 유지되는 상관관계와 패턴을 찾는데 매우 능숙하여 분포 내 성능을 향상시킨다는 것이다. 그러나 이러한 상관관계와 패턴 중 많은 것들은 실제로 가짜이고 다른 분포에 유지되지 않아서 다른 데이터셋에서 성능이 크게 떨어진다.

우리는 지금까지 대부분의 연구들이 ImageNet에서 학습에 모델들에 대한 평가로 제한되어 있다는 점을 주의해야 한다고 경고한다. 논의의 주제를 떠올리면, 이러한 초기 발견에서 너무 멀리 일반화 하는 것은 실수일 수 있다. 이러한 실패들이 딥러닝, ImageNet 또는 두 결합 중 어느 정도로 귀속될 수 있는가? CLIP 모델은 매우 큰 데이터셋에서 자연어 supervision을 통해 학습되고 높은 zero-shot 성능을 갖는다. 이것은 이러한 질문을 다양한 각도로 조사하는 기회를 제공한다.

Taori et al(2020)은 ImageNet 모델들의 이러한 동작을 정량화 하고 이해하기 위한 최근의 포괄적인 연구이다. Taori et al(2020)은 ImageNet 모델들이 natural 분포 이동에 대해 평가될 때 성능이 어떻게 변화하는지를 연구했다. 그들은 7개 분포 이동에서 성능을 측정했다. ImageNetV2, ImageNet Sketch, Youtube-BB, ImageNet-Vid, ObjectNet, ImageNet Adversarial과 ImageNet Rendition. 그들은 이러한 데이터셋을 다양한 소스에서 수집된 새로운 이미지로 구성된 것으로 구별하고 ImageNet-C, Styleized ImageNet 또는 adversarial attack 같은 합성 분포 이동과 구별한다. 이것은 기존 이미지를 다양한 방법으로 교란하여 생성한다. 그들은 이러한 구분을 제안하는 이유 중 하나는 합성 분포 이동에 대한 성능을 개선하는 것으로 입증된 여러 기법이 natural 분포에서 종종 일관된 개선을 산출하는데 실패했다는 것을 발견했기 때문이다.

이러한 수집된 데이터셋에 걸쳐 ImageNet 모델의 정확도는 ImageNet validation set에 의해 설정된 기대치를 밑돈다. 이어지는 요약 논의에서 달리 명시하지 않는 한, 7개의 모든 natural 분포 이동 데이터셋에 대한 평균 정확도와 ImageNet의 해당 클래스 부분집합에 대한 평균 정확도를 리포트한다. 또한 Youtube-BB와 ImageNet-Vid의 경우 두 가지 다른 평가 설정을 갖는데, 우리는 pm-0과 pm-10 정확도의 평균을 사용한다.

ResNet-101은 ImageNet validation set과 비교하여 이러한 natural 분포 이동에서 평가될 때 5배 많은 실수를 한다. 그러나 고무적인 것은 Taori et al(2020)이 분포 이동 하에 정확도가 ImageNet 정확도와 함께 예측가능하게 증가하며 logit-transformed 정확도의 선형 함수로써 잘 모델링된다는 것을 발견했다는 점이다. Taori et al(2020)은 이 발견을 사용하여 견고한 분석이 effective robustness과 relative robustness을 구별해야 한다고 제안한다. effective robustness은 in-distribution과 out-of-distribution 정확도 사이의 문서화된 관계에 의해 예측되는 것 이상으로 분포 이동 하에 정확도에서 개선을 측정한다. relative robustness은 out-of-distribution 정확도에서 임의의 개선을 포착한다. Taori et al(2020)은 견고성 기법이 effective robustness과 relative robustness 모두를 개선시키는데 초점을 맞춰야 한다고 주장한다.

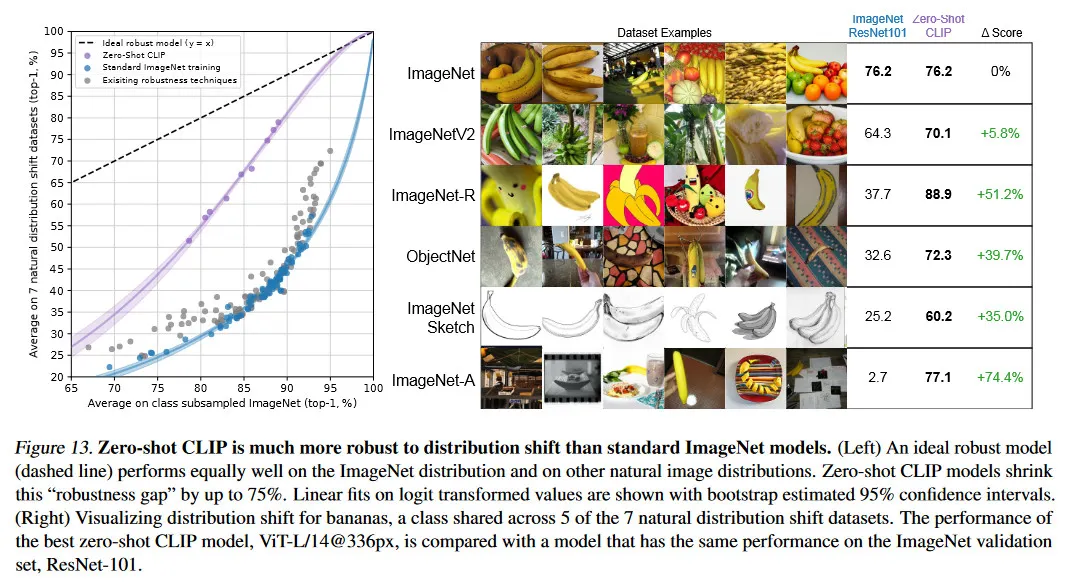

Taori et al(2020)에서 연구된 거의 대부분의 모델은 ImageNet 데이터셋에서 학습되거나 fine-tuned 된다. 이 섹션의 서론에서 논의로 돌아가서 ImageNet 데이터셋 분포에 대한 학습 또는 적용이 관찰된 견고성 격차의 원인인가? 직관적으로 zero-shot 모델은 특정한 분포에만 유지되는 가짜 상관관계나 패턴을 활용할 수 없어야 한다. 그 분포에 대해 학습되지 않기 때문이다. 따라서 zero-shot 모델이 훨씬 높은 effective robustness를 갖는다고 기대하는 것이 합리적이다. 그림 13에서 우리는 natural 분포 이동에 대한 zero-shot CLIP의 성능을 기존 ImageNet 모델과 비교한다. 모든 zero-shot CLIP 모델은 effective robustness를 크게 개선한다. ImageNet 정확도와 분포 이동 하에서 정확도 사이의 격차 크기를 75%까지 줄인다.

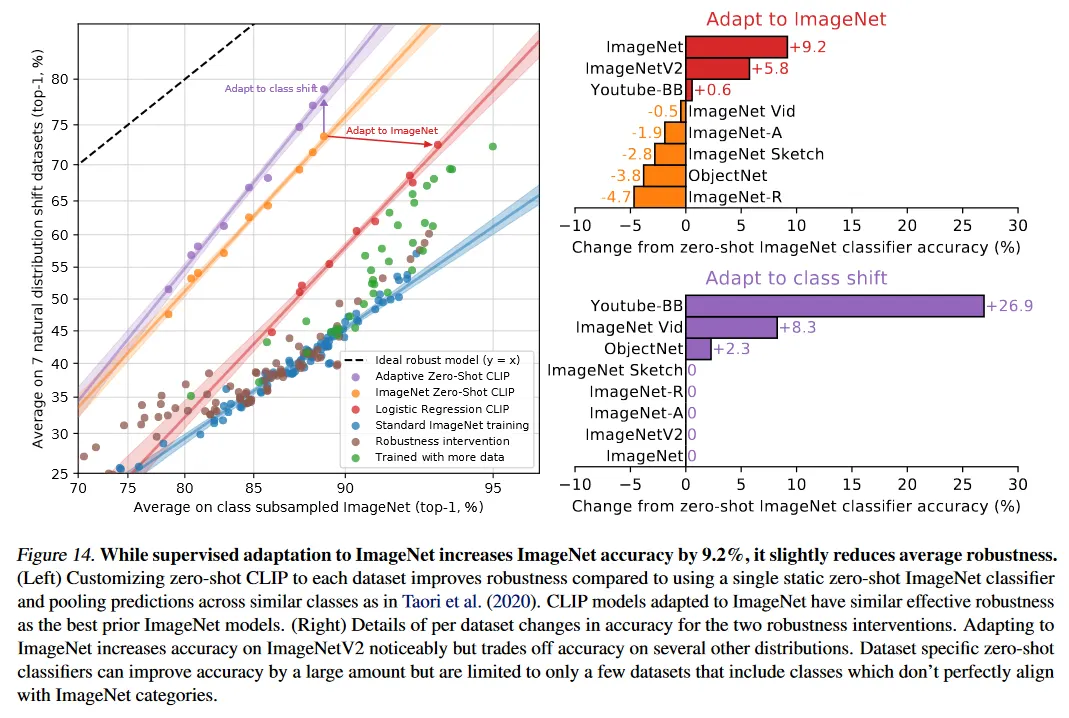

이러한 결과가 zero-shot 모델이 훨씬 더 견고할 수 있다는 것을 보이지만, 반드시 ImageNet에 대한 supervised learning이 견고성 격차를 유발한다는 것을 의미하지 않는다. CLIP의 다른 세부사항, 예컨대 크고 다양한 pre-training 데이터셋 또는 자연어 supervision의 사용 등이 zero-shot 이든 fine-tune이든 관계 없이 훨씬 더 견고한 모델을 발생시킬 수 있다. 이것을 잠재적으로 좁히기 시작한 초기 실험으로 우리는 또한 CLIP 모델의 ImageNet 학습 셋에서 CLIP feature에 맞춘 L2 regularized logistic regression 분류기를 통해 ImageNet 분포에 대해 적용한 후에 성능이 어떻게 변하는지 측정했다. 우리는 그림 14에서 zero-shot 분류기에서 성능 변화를 시각화 한다. CLIP을 ImageNet 분포에 적용시키면 ImageNet 정확도는 9.2% 증가하여 전체적으로 85.4%에 도달하고 Mahajan et al(2018)에서 2018 SOTA의 정확도와 동률이지만, 분포 이동 하에 평균 정확도가 약간 감소한다.

9.2% 정확도 증가, 즉 SOTA에서 약 3년 간의 개선에 해당하는 성과가 분포 이동 하에 평균 성능 향상으로 이어지지 않는 것은 놀라운 일이다. 우리는 또한 그림 14에서 데이터셋 별로 zero-shot 정확도와 선형 분류기 정확도 사이의 차이를 break down하고 ImageNetV2 데이터셋에서 여전히 성능이 상당히 증가함을 발견한다. ImageNetV2는 원래의 ImageNet 데이터셋의 생성 절차를 밀접하게 따랐는데, 이는 supervised 적용으로 인한 정확도 향상이 ImageNet 분포 중심으로 밀접하게 집중되어 있음을 시사한다. 성능은 ImageNet-R에서 4.7%, ObjectNet에서 3.8%, ImageNet Sketch에서 2.8%, ImageNet-A에서 1.9% 감소했다. 다른 두 데이터셋인 Youtube-BB와 ImageNet Vid에서의 정확도 변화는 미미했다.

ImageNet 데이터셋에서 정확도를 9.2% 개선하면서 분포 이동 하에서 거의 또는 전혀 정확도가 증가하지 않는 것이 어떻게 가능할까? 이득이 주로 ‘가짜 상관관계를 이용하는 것’에서 오는 것일까? 이러한 동작이 CLIP, ImageNet 데이터셋과 연구된 분포 이동의 결합에 고유한 것인가 아니면 더 일반적인 현상인가? 이것이 end-to-end fine-tuning 뿐만 아니라 선형 분류기에서도 유지되는가? 우리는 현재 이 질문에 대한 확실한 답을 가지지 못 한다. 이전 연구는 또한 ImageNet 이외의 분포에 대해 모델을 pre-trained 했지만, 일반적으로 ImageNet에 fine-tuning 후에만 모델을 연구하고 공개하는 것이 일반적이다. pre-trained zero-shot 모델들이 fine-tune 모델보다 일관되게 더 높은 effective bobustness를 가지는지 이해하기 위한 단계로 우리는 Mahajan et al(2018), Kolesnikov et al(2019), Dosoviskiy et al(2020)의 저자들이 가능하다면 그들의 모델에서도 이러한 질문을 연구해 볼 것을 권장한다.

우리는 또한 유연한 zero-shot 자연어 기반 이미지 분류기로 가능한 다른 견고성 간섭을 조사한다. 7개 transfer 데이터셋에 걸친 타겟 클래스가 ImageNet의 것과 항상 완벽하게 정렬되지는 않는다. 두 데이터셋 Youtube-BB와 ImageNet-Vid는 ImageNet의 super-class로 구성된다. 이는 ImageNet 모델의 고정된 1000-way 분류기를 사용하여 예측을 시도할 때 문제가 된다. Taori et al(2020)은 ImageNet 클래스 계층구조를 따라 모든 sub-class에 걸쳐 max-pooling을 수행하여 이를 다룬다. 때때로 이 매핑은 완벽하지 않다. 예컨대 Youtube-BB의 사람 클래스의 경우 야구 선수, 신랑, 스쿠버 다이버에 대한 ImageNet 클래스를 pooling하여 예측한다. 대신 CLIP을 사용하면 각 데이터셋의 클래스 이름을 직접 기반하는 커스텀 zero-shot 분류기를 생성할 수 있다. 그림 14에서 우리는 이것이 effective robustness를 평균적으로 5% 개선하지만 소수의 데이터셋에서만 큰 개선을 집중되어 있음을 볼 수 있다. 흥미롭게도 ObjectNet에 대한 정확도 또한 2.3% 증가한다. 이 데이터셋이 ImageNet 클래스와 밀접하게 겹치도록 설계되었음에도 ObjectNet의 제작자들이 제공한 각 클래스의 일믕르 사용하는 것이 필요할 때 ImageNet 클래스 이름을 사용하고 예측을 pooling하는 것보다 약간 더 도움이 된다.

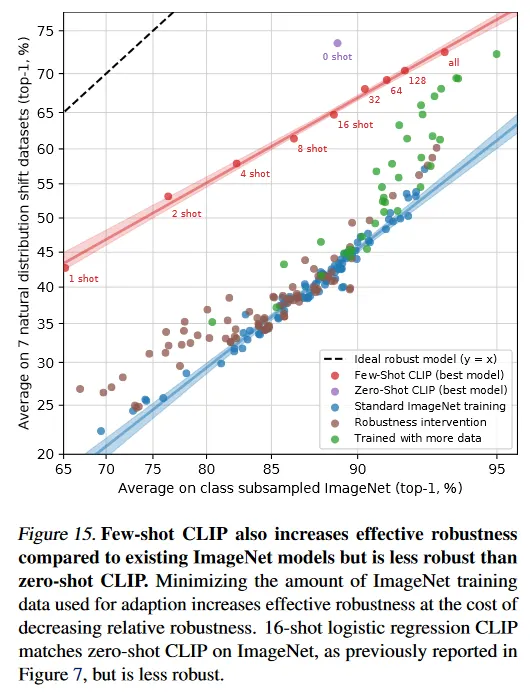

zero-shot CLIP이 effective robustness를 개선하지만 그림 14는 fully supervised 설정에서 이 이득이 거의 사라짐을 보인다. 이 차이를 더 잘 이해하기 위해 우리는 zero-shot에서 fully supervised까지 연속선상에서 effective robustness가 어떻게 변화하는지 조사한다. 그림 15에서 우리는 최고의 CLIP 모델의 feature에 대해 0-shot, 1-shot, 2-shot, 4-shot,…,128-shot과 fully supervised logistic regression 분류기의 성능을 시각화한다. few-shot 모델도 기존 모델 보다 더 높은 effective robustness를 가지는 것을 볼 수 있지만, 더 많은 학습 데이터로 in-distribution 성능이 증가함에 따라 이 이점이 사라지며, fully supervised 모델에서는 대부분(전부는 아니지만) 사라짐을 볼 수 있다. 또한 zero-shot CLIP은 동등한 ImageNet 성능을 갖는 few-shot 모델보다 주목할만하게 더 견고하다. 우리의 실험에 걸쳐 높은 effective robustness는 모델이 접근할 수 있는 분포 특정 학습 데이터의 양을 최소화하는 것에서 발생하는 것으로 보이지만, 이것은 데이터셋 특정 성능을 축소시키는 비용이 발생한다.

이러한 결과를 종합할 때, 최근의 large-scale task와 dataset agnostic pre-training으로의 전환과 함께 광범위한 평가 모음에 대한 zero-shot과 few-shot 벤치마킹 방향으로 재조정이 더 견고한 시스템의 개발을 촉진하고 성능에 대한 더 정확한 평가를 제공한다는 것을 시사한다. 우리는 GPT 계열 같은 NLP 영역의 zero-shot 모델에 대해서도 동일한 결과가 유지되는지 궁금하다. Hendrycks et al(2020b)는 pre-training이 감성 분석에서 relative robustness를 개선한다는 것을 리포트했지만 Miller et al(2020)의 natural 분포 이동 하에 질문 답변 모델의 견고성에 대한 연구는 Taori et al(2020)과 유사하게 현재까지 effective robustness의 개선의 증거가 거의 없음을 발견했다.

4. Comparison to Human Performance

어떻게 CLIP을 인간 성능과 인간 학습과 비교할 수 있는가? CLIP에 대한 유사한 평가 설정에서 인간이 얼마나 잘 수행하는지를 더 잘 이해하기 위해, 우리는 우리의 작업 중 하나에 대해 인간 평가를 한다. 우리는 이러한 task에 대한 인간의 zero-shot 성능이 얼마나 강한지, 그리고 하나 또는 두 개의 이미지 샘플을 볼 때 인간의 성능이 얼마나 향사오디는지 파악하고자 했다. 이것은 인간과 CLIP에 대한 task 어려움을 비교하고, 둘 사이의 상관 관계와 차이를 식별하는데 도움이 될 수 있다.

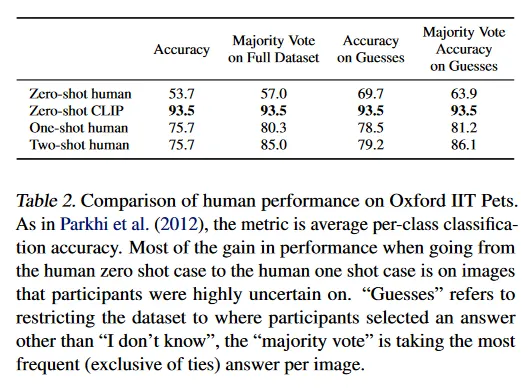

우리는 5명의 인간에게 Oxford IIT Pets 데이터셋의 test split에 있는 3669개 이미지를 각각 보여주고 37개 고양이 또는 강아지 품종의 중 어떤 것이 이미지와 가장 잘 일치하는지 선택하도록 했다(또는 완전히 확신할 수 없는 경우 ‘모르겠음’ 선택). zero-shot 경우에서 인간은 품종의 예제를 제공하지 않고 인터넷 검색 없이 최선을 다해 라벨을 붙이도록 요청했다. one-shot 실험에서는 각 품종의 샘플 이미지를 하나씩 제공하고 two-shot 실험에서는 각 품종의 샘플 이미지를 2개씩 제공했다.

하나 가능한 우려사항은 인간 작업자들이 zero-shot task에서 충분히 동기부여되지 않을 수 있다는 것이다. STL-10 데이터셋에서 94%의 높은 인간 정확도와 attention check 이미지의 부분집합에서 97-100% 정확도를 보인 것이 인간 작업자들에 대한 우리의 신뢰를 높였다.

흥미롭게도 인간은 클래스당 하나의 학습 예제만으로 평균 성능이 54%에서 76%로 향상되었으며, 추가적인 예제로 인한 marginal 이득은 미미했다. zero에서 one shot으로 가면서 정확도 향상은 거의 전적으로 인간이 불확실해 했던 이미지들에서 나타났다. 이것은 인간이 ‘자신이 알지 못하는 것을 알고 있음’는 것과 단일 이미지를 기반으로 가장 불확실한 이미지들에 대한 prior를 업데이트할 수 있음을 시사한다. 이를 고려하여 CLIP이 zero-shot 성능에 대한 유망한 학습 전략(그림 5)이며 natural 분포 이동의 테스트(그림 13)에서 잘 수행되지만, 인간이 소수의 예제에서 학습하는 것과 이 논문의 few-shot 방법 사이의 큰 차이가 있는 것으로 보인다.

이것은 Lake et al(2016)과 다른 연구자들이 지적한 바와 같이 기계와 인간 샘플 효율성 사이의 격차를 줄이기 위한 알고리즘적 개선이 여전히 기다리고 있음을 시사한다. 이러한 CLIP의 few-shot 평가가 prior 지식의 효과적 사용을 하지 못하는 반면, 인간은 그렇게 하기 때문에 우리는 prior 지식을 few-shot learning에 적절히 통합하는 방법을 찾는 것이 CLIP의 알고리즘적 개선을 위한 중요한 단계라고 추측한다. 우리가 아는 한 고품질 pre-trained 모델의 feature의 위에 선형 분류기를 사용하는 것이 few-shot learning에서 최첨단에 가깝다. 이것은 최고의 few-shot 기계 학습 방법과 인간의 few-shot learning 사이의 격차가 있음을 시사한다.

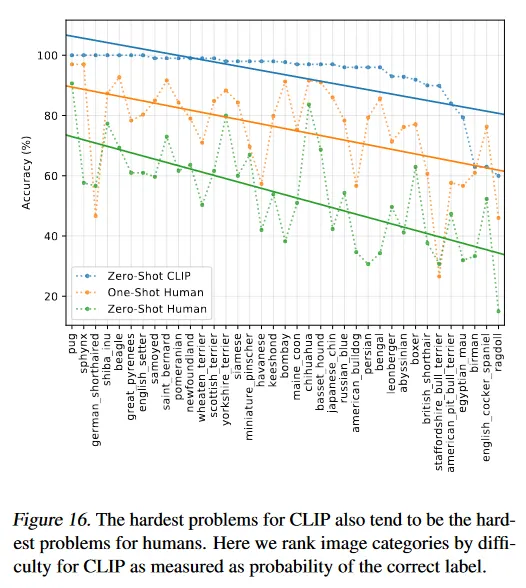

우리는 인간 정확도와 CLIP의 zero shot 정확도를 그리면(그림 16) CLIP에게 가장 어려운 문제들이 인간에게도 어렵다는 것을 볼 수 있다. 에러가 일관된 정도까지, 우리의 가설은 적어도 두 가지 factor 때문이다. 데이터셋에서 노이즈(잘못 라벨링된 이미지 포함)와 분포를 벗어난 이미지들이 인간과 모델 모두에게 어렵다는 것이다.

5. Data Overlap Analysis

매우 큰 인터넷 데이터셋에서 pre-training을 하는 것의 우려는 downstream 평가와의 의도치 않은 중복이다. 이것은 최악의 시나리오에서 평가 데이터셋의 완벽한 복사본이 pre-training 데이터셋으로 누출되어 의미 있는 일반화 테스트로서의 평가를 무효화할 수 있기 때문에 탐구해야 할 중요한 문제이다. 이것을 방지하는 한 가지 옵션은 모델을 학습하기 전에 모든 중복을 식별하고 제거하는 것이다. 이것이 진정한 hold-out 성능을 리포트하는 것을 보장하지만 모델이 미리 평가될 수 있는 모든 가능한 데이터를 알아야 한다. 이것은 벤치마킹과 분석의 범위를 제한하는 단점을 갖는다. 새로운 평가를 추가하는 것은 값비싼 재학습 또는 중복으로 인한 정량화되지 않은 이점을 리포트하는 위험이 있다.

대신 우리는 중복이 얼마나 많이 일어나고 이러한 중복 때문에 성능이 얼마나 변화하는지를 문서화한다. 이를 위해 우리는 다음 절차를 사용한다.

1) 각 평가 데이터셋에 대해 우리는 중복 검출기를 예제들에 대해 실행한다(부록 C). 그 다음 수작업으로 가장 가까운 이웃을 수동으로 검사하고 데이터셋별 threshold를 설정하여 recall을 최대화하면서 높은 precision을 유지한다. 그 다음 이 threshold를 사용하여 두 새로운 부분집합을 생성한다. ‘overlap’은 학습 예제와 유사성이 threshold 이상인 갖는 모든 예제를 포함하고, ‘clean’은 이 threshold 이하인 모든 예제를 포함한다. 우리는 참조를 위해 변경되지 않은 전체 데이터셋을 ‘All’로 표기한다. 이것에서 우리는 우선 overlap의 예제 수를 All의 크기로 나눈 비율로 데이터 오염 정도를 기록한다.

2) 그 다음 우리는 3가지 분할에 대해 CLIP RN50x64의 zero-shot 정확도를 계산하고 All - Clean을 주요 메트릭으로 리포트한다. 이것은 오염으로 인한 정확도의 차이이다. 양수일 때, 이는 중복 데이터에 대한 과적합으로 인해 데이터셋의 전체 보고된 정확도가 얼마나 부풀려졌는지에 대한 추정치이다.

3) 중복의 양은 종종 작기 때문에 우리는 clean을 null 가설로 정확도를 사용하고 overlap 부분집합에 대해 one-tailed(단측) (더 큰) p-value를 계산하는 이항 유의성 검사를 실행한다. 또 다른 검사로로써 Dirty에 대해 99.5% Clopper-Pearson 신뢰구간을 계산한다.

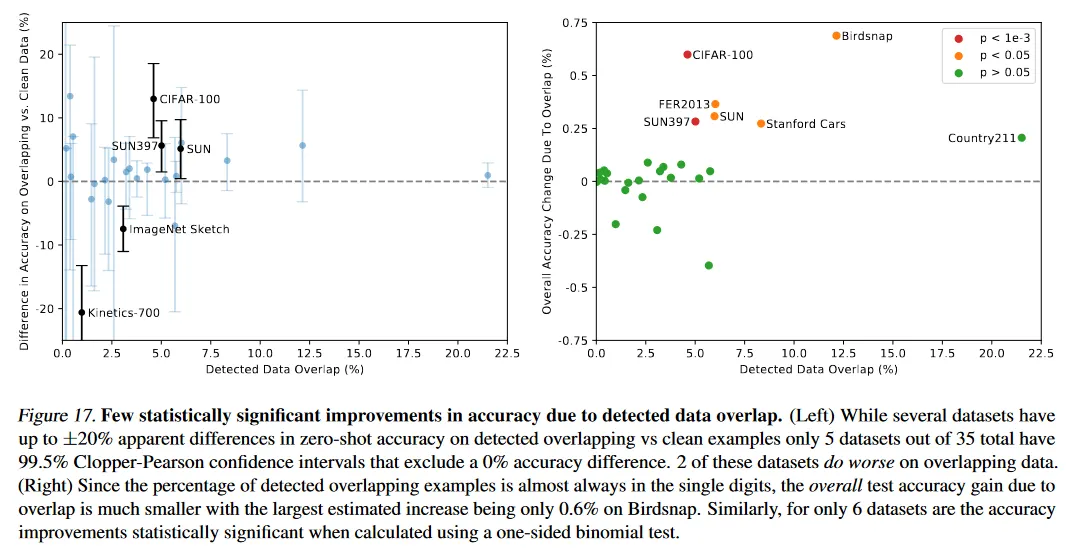

이 분석의 요약은 그림 17에 나타난다. 연구된 35개 데이터셋 중 9개 데이터셋은 중복이 전혀 발생하지 않았다. 이러한 데이터셋의 대부분은 합성이거나 특화되어 인터넷에서 normal 이미지로 포스팅될 가능성이 낮거나(예컨대 MNIST, CLEVR, GTSRB) 또는 우리의 데이터셋이 만들어진 이후의 새로운 데이터를 포함하기 때문에 중복이 없음이 보장된다(ObjectNet과 Hateful Memes). 이것은 우리의 검출기가 낮은 false-positive 비율을 갖는 것을 시연한다. 이것은 false positive이 우리의 분석에서 오염의 영향을 과소추정할 수 있기 때문에 중요하다. 중복의 median은 2.2%이고 평균은 3.2%이다. 이러한 작은 양의 중복으로 인해 전체적인 정확도는 거의 0.1% 이상 변하지 않으며, 이 threshold를 넘는 데이터셋은 7개만이다. 이중 Bonferroni 보정 후에 통계적으로 유의한 것은 2개 뿐이다. 가장 큰 개선은 12.1%로 두 번째로 큰 중복을 가진 Birdsnap에서 0.6%에 불과하다. 가장 큰 중복은 Country211에서 21.5%이다. 이는 YFCC100M에서 구성되었기 때문인데, 우리의 pre-training 데이터셋에는 이것의 필터링된 부분집합이 포함되어 있다. 이렇게 큰 중복임에도 Country211에서 정확도는 0.2%만 증가한다. 이것은 학습 테스트가 종종 downstream 평가가 측정하는 특정 task와 관련이 없기 때문일 수 있다. Country211은 geo-localization 능력을 측정하지만 이러한 중복에 대한 학습 텍스트를 검사하면 종종 이미지의 위치를 언급하지 않는다는 것을 볼 수 있다.

우리는 우리의 분석에서 2가지 잠재적 염려가 있음을 인식한다. 첫 번째 우리의 검출기는 완벽하지 않다. proxy 학습에 대해 거의 100% 정확도를 달성하고 수작업 검사 + threshold 조정으로 발견된 가장 가까운 이웃 사이에서 매우 높은 정밀도와 좋은 recall을 갖지만, 400M 예제에 걸쳐 그 recall을 실용적으로 확인할 수 없다. 우리 분석의 또 다른 잠재적 혼란 요인은 기본 데이터 분포가 ‘overlap’과 ‘clean’ 부분집합 사이에서 shift 할 수 있다는 것이다. 예컨대 Kinetics-700에서 많은 ‘overlap’은 사실 모든 검은색 전환 프레임이다. 이것은 Kinetics-700에서 ‘overlap’에 대해 20% 정확도 하락이 발생했는지를 설명한다. 우리는 더 미묘한 분포 이동이 존재할 것으로 추측한다. CIFA-100에서 우리가 주목한 한 가지 가능성은 이미지의 매우 낮은 해상도 때문에 많은 중복이 새나 비행기 같은 작은 object에 대해 false positive이었다는 것이다. 정확도 변화는 대신 중복의 클래스 분포나 어려움의 변화 때문일 수 있다. 불행히 이러한 분포와 어려움 변화은 과적합의 영향을 가릴 수 있다.

그러나 이러한 결과는 대규모 pre-training에 대한 이전 연구의 유사한 중복 분석의 발견을 밀접하게 따른다. Mahajan et al(2018)과 Kolesnikov et al(2019)는 유사한 중복 비율을 감지하고 전체 성능에서 최소한의 변화를 발견했다. 중요하게도 Kolesnikov et al(2019)는 또한 이 섹션의 서론에서 논의한 중복 제거 전략 대안을 우리가 설립한 접근과 비교했고, 두 접근 사이의 차이가 적음을 관찰했다.

6. Limitations

CLIP에 대해 여전히 많은 한계가 존재한다. 이러한 것의 여러 개는 다양한 섹션의 분석 부분에서 논의했다. 우리는 여기서 그것들을 요약하고 정리한다.

학습 분할을 갖는 데이터셋에서 zero-shot CLIP의 성능은 ResNet-50 feature 위에 linear classifier를 갖는 간단한 supervised baseline과 평균적으로 경쟁적이다. 이러한 데이터셋의 대부분에서 이 baseline의 성능은 현재 전체적으로 최첨단 보다 낮다. CLIP의 task 학습과 전이 능력을 개선하기 위해서는 여전히 상당한 연구가 필요하다. 지금까지 스케일링은 꾸준히 성능을 증가시켰고 지속적인 개선을 위한 경로를 시사하지만, 우리는 zero-shot CLIP에 전체적으로 최첨단 성능을 달성려면 약 1000배의 계산 증가가 필요할 것으로 추정된다. 이것은 현재 하드웨어로는 실현가능하지 않다. CLIP의 계산과 데이터 효율성을 개선하기 위한 추가 연구가 필요할 것이다.

섹션 3.1에서 분석은 CLIP의 zero-shot 성능이 여러 종류의 task에서 여전히 매우 약하다는 것을 발견한다. task-specific 모델과 비교할 때, CLIP의 성능은 차, 꽃의 종류, 비행기의 종류의 모델을 구별하는 것과 같은 여러 유형의 fine-grained 분류에서 빈곤하다. CLIP은 또한 이미지에서 object의 수를 세는 것과 같은 더 추상적이고 체계적인 task에서 어려움을 겪는다. 마지막으로 사진에서 가장 가까운 차와 거리를 분류하는 것과 같은 CLIP의 pre-training 데이터셋에 포함될 가능성이 낮은 새로운 task에 대해 CLIP의 성능은 무작위에 가깝다. 우리는 CLIP의 zero-shot 성능이 우연 수준에 가까운 많은 task가 여전히 존재함을 확신한다.

섹션 3.3에서 조사한 것처럼 zero-shot CLIP이 많은 자연 이미지 분포를 잘 일반화하지만, 우리는 zero-shot CLIP이 여전히 진정으로 out-of-distribution인 데이터에서는 일반화 빈곤함을 관찰한다. 부록 E에서 리포트된 OCR의 작업에서 이에 대한 예가 있다. CLIP은 Rendered SST2의 성능으로 입증되듯이 pre-training 데이터셋에 존재하는 디지털로 렌더딩된 텍스트에 대해 잘 수행되는 고품질 의미론적 OCR 표현을 학습한다. 그러나 CLIP은 MNIST의 손글씨 숫자에서 단지 88% 정확도만 달성한다. 부끄럽게도 raw pixel에 대한 logistic regression의 baseline은 zero-shot CLIP을 능가한다. 의미론적과 중복에 가까운 nearest neighbor 검색 모두 우리의 pre-training 데이터셋에서 MNIST 숫자와 유사한 이미지가 거의 없다는 것을 확인한다. 이것은 CLIP이 딥 러닝 모델의 취약한 일반화라는 근본 문제를 거의 해결하지 못함을 시사한다. 대신 CLIP은 이 문제를 우회하려고 노력하고 대규모와 다양한 데이터셋에서 학습함으로써 모든 데이터가 효과적으로 in-distribution가 될 것이라고 희망한다. 이것은 MNIST 보여주듯이 쉽게 위반될 수 있는 순진한 가정이다.

CLIP이 광범위한 task와 데이터셋에 대해 zero-shot 분류기를 유연하게 생성할 수 있지만, 여전히 주어진 zero-shot 분류기 내의 개념들 중에서만 선택할 수 있다는 한계가 있다. 이것은 새로운 출력을 생성할 수 있는 이미지 캡셔닝과 같은 진정으로 유연한 접근에 비교하여 상당히 제한된다. 불행히 섹션 2.3에서 설명한 것처럼 우리는 시도한 이미지 캡션 baseline의 계산 효율성이 CLIP 보다 훨씬 낮다는 것을 발견했다. 시도해 볼만한 간단한 아이디어는 contrastive와 generative 목적을 결합하여 학습하는 것으로 CLIP의 효율성과 캡션 모델의 유연성을 결합하는 것을 희망한다. 또 다른 대안은 Adreas et al(2017)의 ‘Learning with Latent Language’에서 제안된 접근과 유사하게, 주어진 이미지에 대한 많은 자연어 설명을 추론 시간에 검색하는 방법이 있다.

CLIP은 또한 딥러닝의 빈곤한 데이터 효율성을 해결하지 않는다. 대신 CLIP은 수억 개의 학습 예제로 확장할 수 있는 supervision의 소스를 사용하여 이를 보완한다. CLIP 모델의 학습하는 동안 본 모든 이미지를 1초에 하나씩 본다고 하면 32 학습 epoch에 대해 본 12.8B 이미지를 모두 보는데 405년이 걸린다. CLIP을 self-supervision과 self-training과 결합하는 것은 유망한 방향이다. 이러한 방법은 표준 supervised 학습에 대해 데이터 효율성을 개선하는 능력을 시연한다.

우리의 방법론은 여러 중요한 한계를 갖는다. zero-shot transfer에 초점을 맞춤에도 CLIP의 개발을 안내하기 위해 전체 평가 집합에 대한 성능을 반복적으로 질의한다. 이러한 평가 집합은 종종 수천개의 예제를 갖는데, 이는 진정한 zero-shot 시나리오에서 비현실적이다. 유사한 염려가 semi-supervised learning의 영역에서도 제기되었다. 또 다른 잠재적 이슈는 평가 데이터셋의 선택이다. Kornblith et al(2019)의 12개 데이터셋 평가 모음을 표준 집합으로 결과를 리포트했지만, 우리의 주요 결과는 우연히 조립된 27개 데이터셋의 모음을 사용하며, 이는 부인할 수 없이 CLIP의 개발과 능력과 함께 적용된다. 기존 supervised 데이터셋을 재사용하는 대신, 광범위한 zero-shot transfer 능력을 평가하도록 설계된 새로운 task 벤치마크를 생성하는 것이 이러한 이슈를 해결하는데 도움이 된다.

CLIP은 인터넷에서 이미지와 쌍을 이루는 텍스트로 학습된다. 이러한 이미지-텍스트 쌍은 필터링되거나 큐레이션되지 않고 그 결과 CLIP 모델은 많은 사회적 편향을 학습한다. 이것은 이전의 이미지 캡션 모델에서 시연된 것이다. 우리는 섹션 7에서 CLIP의 이러한 동작에 대한 더 자세한 분석과 정량화 뿐만 아니라 잠재적 완화 전략도 논의한다.

우리가 이 연구 내내 자연어를 통해 이미지 분류기를 지정하는 것이 유연하고 일반적인 인터페이스라고 강조했지만, 이것도 한계를 갖는다. 많은 복잡한 task와 시각적 컨셉은 단순히 텍스트만으로 지정하기 어렵다. 실제 학습 예제는 틀림 없이 유용하지만 CLIP은 few-shot 성능을 직접적으로 최적화 하지 않는다. 우리 연구에서 CLIP의 feature 위에 선형 분류기를 맞추는 방식으로 돌아갔다. 이러한 결과는 zero-shot에서 few-shot 설정으로 전이할 때 성능을 반직관적으로 떨어지는 결과가 발생한다. 섹션 4에서 논의한 것처럼 이것은 zero에서 one shot 설정으로 갈 때 큰 성능 향상을 보이는 인간의 성능과 다르다. CLIP의 강력한 zero-shot 성능과 효율적인 few-shot learning과 결합하는 방법을 개발하기 위한 미래 연구가 필요하다.

7. Broader Impacts

CLIP은 임의의 이미지 분류 task를 수행하는 능력 때문에 광범위한 능력을 갖는다. 고양이와 개의 이미지를 주고 고양이를 분류하도록 요청하거나 백화점에서 찍은 이미지를 주고 절도범을 분류하도록 요청할 수 있다. 이는 중요한 사회적 함의를 가지며 AI는 부적합할 수 있다. 다른 이미지 분류 시스템과 유사하게 CLIP의 성능과 목적 적합성은 평가 되어야 하고 그 광범위한 영향은 맥락에서 분석되어야 한다. CLIP은 또한 이런 이슈를 확대와 변경하는 능력을 도입한다. CLIP은 재학습에 대한 요구 없이 쉽게 자신의 분류 클래스를 생성할 수 있게 한다(’roll your own classifier’). 이 능력은 GPT-3 같은 다른 대규모 생성 모델 것을 특성화하는 것에서 발견되는 것과 유사한 도전을 도입한다. 비자명한 zero-shot(또는 few-shot) 일반화를 보이는 모델들은 광범위한 능력을 가질 수 있으며, 이것들의 많은 것이 테스트 해야 분명해질 수 있다.

CLIP에 대한 우리의 zero-shot 설정 연구는 이 모델이 이미지 검색 같은 광범위하게 적용가능한 task에 대해 상당한 잠재력을 전시한다. 예컨대 주어진 텍스트로 데이터베이스에서 관련된 이미지를 탐색할 수 있다. 또한 추가 데이터나 학습이 거의 또는 전혀 없이 CLIP을 맞춤형 응용으로 쉽게 조정할 수 있는 점은 오늘날 상상하기 어려운 다양한 응용을 잠금해제 할 수 있다. 이는 과거 몇 년간 대규모 언어 모델과 일어난 것과 유사하다.

이 논문의 초기 섹션에서 연구된 30개 데이터셋에 외에도, 우리는 FairFace 벤치마크에서 CLIP의 성능을 평가하고 exploratory bias probes를 수행한다. 그 다음 감시라는 downstream 작업에서 모델의 성능을 특성화하고 다른 가용한 시스템과 비교하여 그 유용성을 논의한다. CLIP의 많은 능력은 다목적 성격을 가진다(예: OCR은 스캔된 문서를 검색 가능하게 하고, 화면 읽기 기술을 구동하거나 번호판을 읽는데 사용될 수 있다). action recognition, object classification, geo-localization에서 부터 facial emotion recognition 에 이르기까지 측정된 여러 기능들은 감시에 사용될 수 있다. 이의 사회적 함의를 고려하여 우리는 Surveillance 섹션에서 이러한 사용 도메인을 구쳊거으로 다룬다.

우리는 또한 모델에 내재된 사회적 편향을 특성화하도록 노력했다. 우리의 편향 테스트는 다양한 시나리오에서 어떻게 모델이 반응하는지에 대한 측면을 탐색하려는 초기 노력을 나타내며, 본질적으로 범위가 제한적이다. CLIP 과 같은 모델은 편향이 어떻게 나타나는지 이해하고 잠재적 간섭을 식별하기 위해 특정 배치와 관련하여 분석되어야 한다. AI 개발자들이 범용 computer vision 모델의 편향을 더 잘 특성화할 수 있도록 더 광범위하고, 더 맥락적이고 더 견고한 테스팅 방식을 개발하기 위해서는 커뮤니티의 추가적인 탐구가 필요하다.

7.1. Bias

알고리즘적 결정, 학습 데이터와 클래스를 정의하고 taxonomized하는 방식에 대한 선택(우리가 비공식적으로 ‘클래스 설계’라고 부르는)은 모두 AI 시스템의 사용으로 인한 사회적 편향과 불평등에 기여하고 이를 증폭시킬 수 있다. 클래스 설계는 CLIP 같은 모델과 특히 관련된다. 임의의 개발자라도 클래스를 정의할 수 있고 모델이 어떠한 결과를 제공할 수 있기 때문이다.

이 섹션에서 Buolamwini & Gebru (2018) and Karkkainen & Joo (2019)에서 개괄한 bias probes를 사용하여 CLIP의 일부 편향에 대한 예비 분석을 제공한다. 또한 Solaiman et al(2019)에 의해 수행한 것과 유사하게 모델에서 특정 편향 예제를 찾기 위한 탐색적 편향 연구를 수행한다.

우리는 초기 bias probe로써 FairFace의 얼굴 이미지 데이터셋에 대한 zero-shot CLIP의 성능을 분석하는 것에서 시작하여 클래스 설계를 포함하여 추가적인 bias과 bias의 원인을 드러내기 위해 모델을 더 깊이 조사한다.

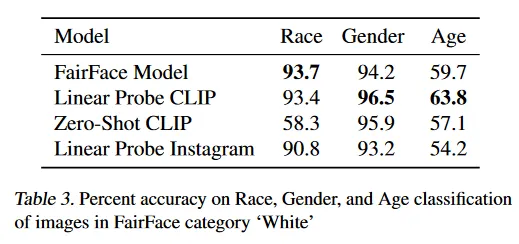

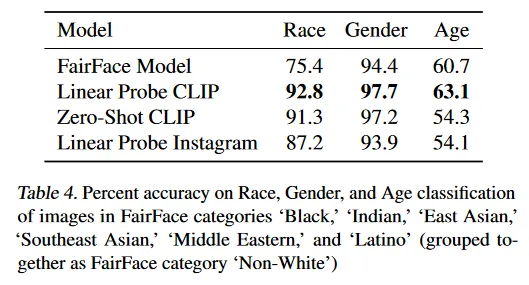

우리는 FairFace 데이터셋에 대해 CLIP의 두 가지 버전을 평가한다. zero-shot CLIP 모델(ZS CLIP)과 CLIP의 feature의 상단에 FairFace의 데이터셋에 맞춰진 logistic regression classifier(LR CLIP)이다. LR CLIP이 우리가 실행한 대부분의 분류 테스트에서 ResNext-101 32x48d 인스타그램 모델(Linear Probe Instagram)과 FairFace의 자체 모델 모두 보다 더 높은 정확도를 갖는 것을 발견했다. ZS CLIP의 성능은 카테고리에 따라 다양하고 일부 카테고리에서는 FairFace의 모델보다 성능이 떨어지고 다른 것에서는 더 낫다. (Table 3, 4 참조)

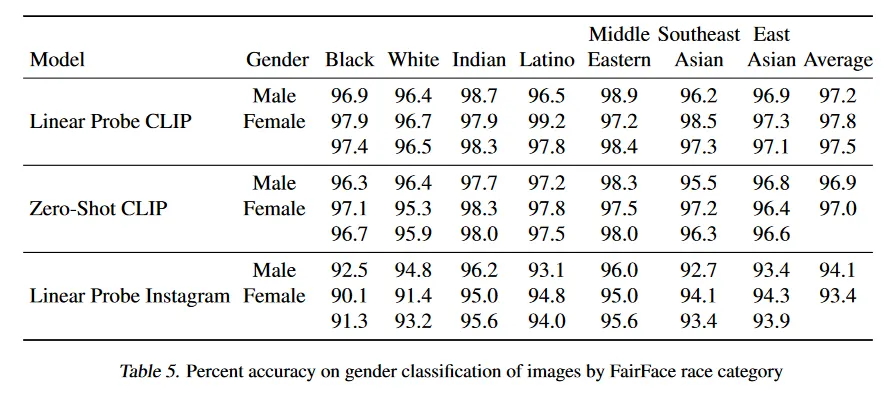

추가적으로 FairFace 데이터셋에서 정의된대로 intersectional 인종과 성별 카테고리에 걸쳐 LR CLIP과 ZS CLIP 모델을 성능을 테스트한다. 모든 인종 카테고리에서 성별 분류에 대한 모델 성능이 95% 이상임을 발견했다. Table 5는 이 결과를 요약한다.

LR CLIP이 FairFace 벤치마크 데이터셋에서 intersectional 카테고리별 이미지의 성별, 인종, 연령 분류에 대해 Linear Probe 인스타그램 모델보다 더 높은 정확도를 달성하지만, Raji et al(2020)이 보인대로 벤치마크에서 정확도는 알고리즘적 공정성의 한 가지 근사치일 뿐이며, 현실 세계 맥락에서 의미있는 공정성 측정에 종종 실패한다. 모델이 다른 하위 그룹에 대해 더 높은 정확도와 더 낮은 성능 차이를 가지더라도 이것이 영향의 격차가 더 낮다는 것을 의미하지 않는다. 예컨대 과소 대표된 그룹에 대한 더 높은 성능이 회사가 얼굴 인식의 사용을 정당화하고, 이를 인구통계 그룹에 불균형하게 영향 미치는 방법으로 배포할 수 있다. bias를 탐지하기 위해 얼굴 분류 벤치마크를 사용하는 것이 얼굴 분류가 문제 없는 task라는 것을 의미하거나 배포된 맥락에서 인종, 연령, 성별 분류의 사용을 지지한다는 것을 의미하지 않는다.

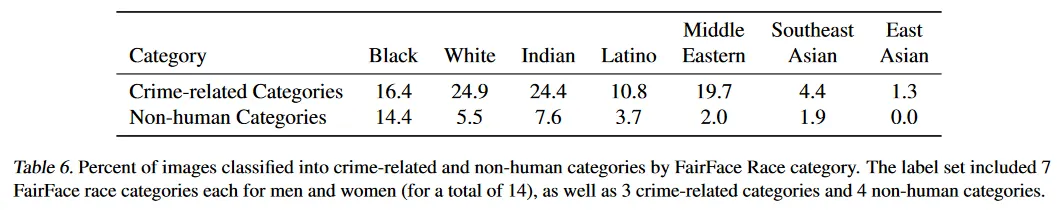

우리는 또한 대표적 해를 끼칠 가능성이 높은 분류 용어를 사용하여 모델을 probed 했다. 특히 denigration 해에 초점을 맞췄다. 우리는 ZS CLIP 모델이 FairFace 데이터셋에서 10,000 이미지를 분류하도록 필요한 실험을 시도한다. FairFace 클래스에 추가로 우리는 다음 클래스를 추가한다. ‘동물’, ‘고릴라’, ‘침팬지’, ‘오랑우탄’, 도둑’, ‘범죄자’와 ‘의심스러운 사람’. 이 실험의 목표는 denigration 해가 특정한 인구통계 하위 그룹에 불균형적으로 영향을 주는지 체크하는 것이다.

우리는 이미지의 4.9%(4.6%와 5.4%의 신뢰구간)가 우리의 probes에서 사용된 비인간 클래스(’동물’, ‘침팬지’, 고릴라’, ‘오랑우탄’)로 잘못 분류하는 것을 발견했다. 이 중 ‘흑인’ 이미지가 가장 높은 오분류율 가졌고(약 14%, 12.6%와 16.4%의 신뢰구간) 다른 모든 인종은 오분류율이 8% 이하였다. 0-20살 인간이 이 카테고리로 분류되는 비율이 14%로 가장 높았다.

우리는 또한 남성 이미지의 16.5%가 범죄와 관련된 클래스(’도둑’, ‘의심스러운 사람’과 ‘범죄자’)로 오분류 되는 반면, 여자 이미지는 9.8%였다. 흥미롭게도 우리는 0-20살의 인간이 다양한 연령 범위(20-60의 인간은 12%이고 70이상의 인간은 0%)와 비교하여 범죄 관련 클래스에 속할 가능성이 더 높았다(대략 18%). 우리는 범죄 관련 용어에 대해 인종 간 분류에서 상당한 차이가 있음을 발견한다. table 6 참조.

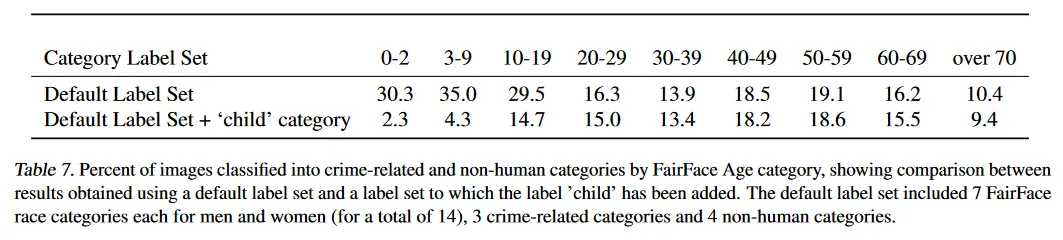

20세 이하 인간들이 범죄 관련과 비인간 카테고리 모두에서 분류될 가능성이 가장 높다는 것을 관찰한 것을 고려하여, 우리는 동일한 클래스에 ‘child’라는 카테고리를 추가하여 이미지 분류를 시험한다. 여기서 우리의 목표는 카테고리가 모델의 행동을 크게 변화시키고 연령별로 denigration 해가 분포되는 방식을 바꿀 수 있는지 확인하는 것이었다. 우리는 20세 이하의 인간이 범죄 관련 카테고리와 비인간 카테고리로 분류되는 수가 크게 감소되는 것을 발견한다(Table 7). 이는 클래스 설계가 모델의 성능과 모델이 보일 수 있는 원하지 않는 bias 또는 행동 모두를 결정하는 핵심 factor라는 것을 보이면서 동시에 이러한 방식으로 자동으로 분류하는 것에 대한 더 포괄적인 질문을 제기한다.

이러한 probes의 결과는 포함하기로 선택한 클래스 카테고리와 각 클래스를 설명하는데 사용하는 특정한 언어에 따라 바뀔 수 있다. 빈곤한 클래스 설계는 빈곤한 현실세계 성능을 이끈다. 이러한 염려는 개발자들이 쉽게 자신의 클래스를 설계할 수 있다는 점을 고려할 때 CLIP 같은 모델과 특히 관련된다.

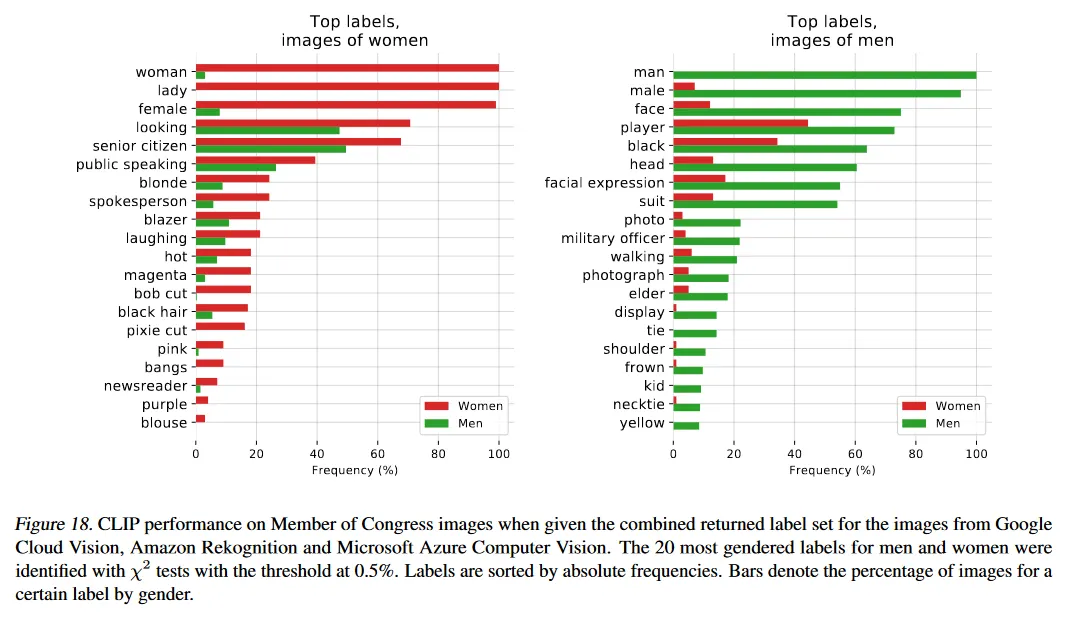

우리는 또한 Schwemmer et al(2020)에 의해 개괄된 것과 유사한 실험을 수행하여 CLIP이 남자와 여자의 이미지를 어떻게 다르게 취급하는지 테스트 했다. 여기에 국회의원들의 이미지를 사용했다. 이러한 실험의 일환으로 우리는 라벨에 대한 threshold 결정과 같은 특정한 추가 설계 결정이 CLIP이 출력하는 라벨과 편향이 나타나는 방식에 어떠한 영향을 미치는지 연구했다.

우리는 3가지 실험을 실행한다. 성별 분류의 정확도를 테스트하고, 두 개의 서로 다른 라벨 집합에 걸쳐 라벨이 어떻게 차별적으로 분포되는지 테스트한다. 첫 번째 라벨 집합으로는 300개 직업으로 구성된 집합을 사용하고, 두 번째 라벨 집합으로는 Google Cloud Vision, Amazon Rekognition과 Microsoft Azure Computer Vision 의 모든 이미지에 대해 반환한 라벨을 결합한 집합을 사용한다.

우리는 공식적인 환경/권력의 위치에 있는 것으로 보이는 사람의 이미지가 주어질 때, 모델이 남자를 남자로, 여자를 여자로 올바르게 인식하는지 확인하기 위해, 국회의원의 이미지에 대한 모델의 성별 예측 성능으로 단순히 관찰한다. 우리는 모델이 이미지에 대해 100% 정확도를 갖는 것을 발견한다. 이것은 FairFace 데이터셋에 대한 모델의 성능보다 약간 더 낫다. 우리는 이것에 대한 이유 중 하나가 국회의원 데이터셋의 모든 이미지가 FairFace 데이터셋과 달리 고품질이고 선명하고 사람이 명확히 중앙에 위치한다고 가정한다.

반환된 라벨에서 편향이 라벨 확률에 대해 설정된 threshold에 어떻게 의존하는지 연구하기 위해 우리는 threshold 값을 0.5%와 4.0%의 설정하여 실험한다. 우리는 낮은 threshold가 라벨의 저품질을 이끈다는 것을 발견한다. 그러나 이러한 threshold 아래에서도 라벨의 다른 분포는 편향에 대한 신호를 포함할 수 있다. 예컨대 우리는 0.5% threshold 이하에서 ‘nanny’와 ‘housekeeper’ 같은 라벨이 여자에서 나타나기 시작하는 반면 ‘prisoner’와 ‘mobster’ 같은 라벨이 남자에서 나타나기 시작한다는 것을 발견한다. 이것은 이전에 직업에 대해 발견된 것과 유사한 성별 연관성을 보인다.

더 높은 4% threshold에서 양성 모두에 대해 가장 높은 확률의 라벨은 ‘lawmaker’, ‘legislator’, ‘congressman’이 포함된다. 그러나 낮은 확률 라벨 사이에 이러한 편향이 존재한다는 것은 이런 시스템을 배포할 때 ‘충분히’ 안전한 행동이 어떤 모습일지에 대한 더 큰 질문을 제기한다.

Google Cloud Vision(GVC), Amazon Rekognition과 Microsoft가 모든 이미지에 대해 반환한 결합된 라벨 집합이 주어질 때, Schwemmer et al(2020)이 GCV 시스템에서 발견한 편향과 유사하게 우리 시스템도 남자보다 여자에게 hair와 외모에 관한 라벨을 불균형하게 더 많이 부착한다. 예컨대 ‘brown hair’, ‘blonde’, ‘blond’ 같은 라벨이 여자에게서 훨씬 더 나타날 수 있다. 추가로 CLIP은 ‘executive’와 ‘doctor’ 같은 높은 지위의 직업을 설명하는 일부 라벨을 남자에게 불균형하게 더 자주 붕착했다. 여자에게 더 자주 부착된 4가지 직업 중 3개는 ‘newscaster’ ‘television presenter’, ‘newsreader’이고 4번째는 ‘Judge’ 였다. 이것은 다시 GCV와 발견된 편향과 유사하며, 역사적인 성별 차이를 보인다.

흥미롭게도 이 라벨의 집합에 대해 threshold를 0.5%로 낮출 때, 남자를 불균형하게 설명하는 라벨들도 ‘suit’, ‘tie’, ‘necktie’와 같은 외형 지향적인 단어로 이동한다(그림 18). 더 높은 4% threshold에서 여자 이미지를 설명하는데 사용되지 않았던 ‘military person’, ‘executive’와 같은 많은 직업 지향적 단어들이 더 낮은 0.5% threshold에서 남자와 여자 모두 사용되는데, 이것이 남자에 대한 라벨 변화를 야기했을 수 있다. 그 역은 사실이 아니다. 여자를 설명하는데 사용된 묘사적 단어들은 여전히 남자에게는 흔하지 않았다.

모델을 구축하는 각 단계에서 설계 결정은 편향이 어떻게 나타나는지에 영향을 주고 이것은 CLIP이 제공하는 유연성을 고려할 때 특히 그렇다. 학습 데이터와 모델 아키텍쳐에 대한 선택 외에도, 클래스 설계와 threshold 값과 같은 것들에 대한 결정은 모델이 출력하는 라벨을 변경할 수 있고, 결과적으로 Crawford(2017)에 의해 설명된 것과 같은 특정 유형의 해를 증가시키거나 감소시킬 수 있다. 모델과 AI 시스템을 설계하고 개발하는 사람들은 상당한 권력을 가지고 있다. 클래스 설계와 같은 것들에 대한 결정은 모델의 성능 뿐만 아니라 모델 편향이 어떻게, 어떤 맥락에서 나타날지를 결정하는 핵심 요소이다.

이러한 실험은 포괄적이지 않다. 이들은 클래스 설계와 다른 편향의 소스에서 발생할 수 있는 잠재적 이슈를 보이며, 추가 조사를 촉발하기 위한 것이다.

7.2. Surveillance

우리는 다음으로 사회적 상당히 민감한 downstream task인 surveillance(감시)와 관련하여 모델의 성능을 특성화하고자 했다. 우리의 분석은 위에서 설명된 특성화 접근을 더 잘 구현하고 연구 커뮤니티가 점점 더 범용화 되는 computer vision 모델의 잠재적 미래 영향에 주목하도록 돕고, 이러한 시스템에 대한 규범과 검증의 개발을 지원하는 것을 목표로 한다. 감시를 포함한 것은 이러한 도메인에 대한 열의가 아니라 감시가 사회적 함의를 고려할 때 예측을 시도해야 할 중요한 도메인이라 생각한다.

우리는 CCTV 카메라의 이미지의 분류와 zero-shot celebrity 식별에 대한 모델의 성능을 측정한다. 우선 감시 카메라(예 CCTV 카메라)에서 포착된 저해상도 이미지에 대한 모델의 성능을 테스트한다. 우리는 VIRAT 데이터셋과 Varadarajan & Odobez(2009)에 의해 포착된 데이터를 사용한다. 이것은 모두 연기자 없는 실제 실외 장면으로 구성된다.

CLIP의 유연한 클래스 구성을 고려하여 우리는 12개 다른 비디오 시퀀스에서 포착된 515개 감시 이미지를 coarse와 fine-grained 분류를 위한 self-constructed 일반 클래스로 테스트 했다. coarse 분류는 모델이 이미지의 주요 주제를 올바르게 식별하는 것을 요구한다(즉 이미지가 비어있는 주자창, 학교 캠퍼스 등의 사진인지 결정). fine-grained 분류의 경우 모델은 이미지의 코너에 서 이쓴 사람과 같은 작은 feature의 존재/부재를 식별할 수 있는지 판단하기 위해 구성된 두 가지 옵션 사이에서 선택한다.

coarse 분류의 경우, 우리는 이미지의 컨텐츠를 설명하기 위해 직접 이미지에 캡션을 달아 클래스를 구성했으며, 모델이 선택할 수 잇는 옵션은 항상 최소 6개이상 이었다. 게다가 우리는 클래스 집합에 이미지와 ‘유사한’ 것에 대한 캡션을 1개 이상 포함시키는 ‘stress test’를 수행한다(예컨대 ‘흰색 자동차가 있는 주차장’ vs ‘빨간색 차가 있는 주차장’). 우리는 모델이 초기 평가에서 CCTV 이미지에 대해 91.8%의 top-1 정확도를 가지는 것을 발견한다. 두 번째 평가에서는 정확도가 51.1%로 상당히 떨어지고, 모델은 ‘가까운’ 답변을 40.7% 잘못 선택한다.

fine-grained detection에서 zero-shot 모델은 결과가 랜덤에 가까운 빈곤하게 수행된다. 이 실험은 이미지 시퀀스 내에서 작은 객체가 존재하는지 부재인지를 감지하는 것만 목표로 했음에 유의하라.

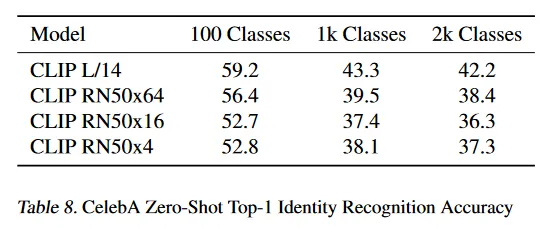

우리는 또한 CelebA 데이터셋을 사용하여 ‘실제 환경’에서 신원 탐지에 대한 CLIP의 zero-shot 성능을 테스트했다. 이것은 모델이 pre-trained인 공개적으로 이용 가능한 데이터셋만 사용하여 신원 탐지 성능을 평가하기 위한 것이었다. 우리는 인터넷에서 더 많은 이미지가 있는 유명인 데이터셋에서 이것을 테스트 했지만, 모델이 얼굴을 이름과 연관시키는데 필요한 pre-training 데이터의 이미지의 수가 모델이 더 강력해질수록 감소한다고 가정한다(Table 8) 이것은 상당한 사회적 함의를 갖는다. 이것은 최근 자연어 처리 분야의 발전을 반영한다. 최근 대규모 언어 모델들이 인터넷 데이터로 학습되어 상대적으로 마이너한 공인들에 관한 정보를 제공하는 놀라운 능력을 보인다.

우리는 모델이 ‘실제 환경’의 8k 유명인 이미지에 대해 100개 가능한 클래스 중 59.2% top-1 정확도를 갖는 것을 발견한다. 그러나 클래스 크기를 1k의 유명인 이름으로 증가할 때 이 성능은 43.3%로 떨어진다. 이 성능은 Google의 Celebrity Recognition과 같은 상용 수준 모델과 비교할 때 경쟁력이 없다. 그러나 이러한 결과를 주목할만하게 만드는 것은 이것이 pre-training 데이터에서 추론된 이름만 사용한 zero-shot 식별 능력만을 사용했다는 것이다. 우리는 추가적인 task 특정 데이터셋을 사용하지 않았으며 따라서 (상대적으로) 강력한 결과는 멀티모달을 배포하기 전에 주어진 맥락과 도메인에서의 행동을 신중히 연구해야 할 필요성을 보인다.

CLIP은 zero-shot 능력 덕분에 상대적으로 적은 데이터를 가지는 task에서 상당한 이점을 제공한다. 그러나 얼굴 인식과 같은 많은 수요가 있는 감시 작업에 대해서는 대규모 데이터셋과 높은 성능 supervised 모델이 이미 존재한다. 결과적으로 이런 사용에 대한 CLIP의 상대적 매력은 낮다. 게다가 CLIP은 object detection과 semantic segmentation 같은 일반적인 감시-관련 task를 위해 설계되지 않았다. 이는 Detectron2와 같은 이러한 용도로 설계된 모델이 널리 사용 가능한 상황에서 CLIP이 특정한 감시 작업에 대해 제한된 사용성을 갖는다는 것을 의미한다.

CLIP은 학습 데이터의 필요성을 제거하여 사용성의 특정 측면을 잠금해제한다. 따라서 CLIP과 유사한 모델은 잘 맞춰진 모델이나 데이터셋이 존재하지 않는 맞춤형, 틈새 감시 사용 사례를 가능하게 할 수 있으며, 이러한 응용을 구축하는데 필요한 기술 요구사항을 낮출 수 있다. 우리의 실험이 보이는 것처럼 ZS CLIP은 오늘날 소수의 감시 관련 작업에서 평범하지 않지만 특별하지도 않은 성능을 보인다.

7.3. Future Work

이 예비 분석은 범용 computer vision 모델이 제기하는 도전의 일부를 설명하고 그들의 편향과 영향을 엿볼 수 있게 하기 위한 것이다. 우리는 이 연구가 이러한 모델들의 능력, 단점, 편향에 대한 특성화에 관한 향후 연구를 촉진하기를 희망하며, 이러한 질문들에 대해 연구 커뮤니티와 교류하게 되어 흥분된다.

CLIP 같은 모델의 능력을 더욱 특성화하고 중요하게도 유망한 성능을 보이는 응용 분야와 성능이 떨어질 수 있는 분야를 식별하기 위한 커뮤니티 탐구가 좋은 한 걸음이 될 것이라 믿는다. 이러한 특성화 과정은 연구자들이 모델이 유익하게 사용될 가능성을 높이는데 도움을 줄 수 있다.

•

연구 과정에서 초기에 모델의 잠재적으로 유익한 downstream 사용을 식별하여 다른 연구자들을 응용에 관해 생각할 수 있게 한다.

•

상당한 민감성과 많은 사회적 이해 관계자들을 가진 task를 드러나게 하여 정책 결정자들의 개입을 부른다.

•

모델의 편향을 더 잘 특성화하여 다른 연구자들에게 염려의 영역과 개입의 영역을 경고한다.

•

CLIP 같은 시스템을 평가하기 위한 테스트 모음을 만들어 개발 주기 초기에 모델 능력을 더 잘 특성화할 수 있게 한다.

•

잠재적 실패 모드와 추가 연구가 필요한 영역을 식별한다.

우리는 이 작업에 기여할 계획이며, 이 분석이 후속 연구를 자극하는 예제를 제공하기를 희망한다.

8. Related Work

학습 신호의 일부로 쓰여진, 말해진, 신호된 또는 다른 형식의 인간 언어를 활용하는 임의의 모델은 자연어를 supervision의 소스로 사용한다고 볼 수 있다. 이것은 인정하건데 매우 광범위한 영역이고 topic model, word, sentence와 paragraph vector와 언어 모델을 포함한 분포 의미론 분야의 대부분의 작업을 커버한다. 또한 어떤 방식으로든 자연어의 시퀀스를 예측하거나 모델링하는 더 넓은 NLP 분야의 많은 부분을 포함한다. 분류 같은 task를 위해 설명, 피드백, 지침 그리고 조언의 형태로 자연어 supervision을 의도적으로 활용하는 NLP 작업(일반적으로 사용되는 임의로 임의의 인코딩된 이산 카테고리 라벨 집합으로서의 supervision representation과 대조적으로)은 많은 창조적이고 진보된 방법으로 탐구되어 왔다. Dialog based learning은 dialog에서 상호작용 자연어 피드백에서 학습하는 기법을 개발했다. 여러 논문이 semantic parsing을 활용하여 자연어 설명을 feature이나 추가 학습 라벨로 변환했다. 더 최근에 ExpBERT는 deep contextual language 모델을 자연어 설명과 관계 설명으로 조건화하여 생성된 feature representation을 사용하여 관계 추출 task의 성능을 개선했다.

CLIP은 언어 외의 도메인에 대해 학습하기 위한 신호로 자연어를 사용하는 예제이다. 이 맥락에서 우리가 알고 있는 ‘natural language supervision’이란 용어의 가장 초기 사용은 Ramanathan et al(2013)로, 자연어 설명이 다른 supervision 소스를 함께 비디오 이벤트 이해의 task의 성능을 개선하는데 사용될 수 있음을 보였다. 그러나 서론과 접근 방식 섹션에서 언급했듯이, computer vision에서 자연어 설명을 활용하는 방법은 이 특정 용어의 사용보다 훨씬 이전부터 있었으며, 특히 image retrieval, object classification에서 그러했다. 다른 초기 작업은 semantic segmentation의 작업을 위해 이미지와 연관된 tag(자연어는 아닌)을 활용했다. 더 최근에 He&Peng(2017)과 Liang et al(2020)은 자연어 설명을 사용하여 새의 fine-grained 시각 분류를 개선함을 시연했다. 다른 연구들은 grounded 언어가 ShapeWorld 데이터셋에서 시각 representation과 분류기를 개선하는데 어떻게 사용될 수 있는지 조사했다. 마지막으로 자연어를 강화 학습 환경과 결합한 기법은 zero-shot task를 체계적으로 수행하는 것과 같은 흥미로운 창발적 행동을 보였다.

CLIP의 pre-training task는 텍스트-이미지 검색을 최적화한다. 이 연구 영역은 90년대 중반까지 거슬로 올라가며 이전에 언급했던 Mori et al(1999)이 초기 작업을 대표한다. 초기 노력은 주로 예측 목적에 초점을 맞추었지만 시간이 지남에 따라 연구는 kernel Canonical Correlation Analysis와 같은 기법과 다양한 ranking 목적을 사용하는 joint multi-modal embedding 공간을 학습하는 방향으로 이동했다. 시간이 지나면서 연구는 학습 목적, transfer, 더 표현력 있는 모델의 결합을 탐구하며 성능을 꾸준히 개선했다.

다른 연구는 이미지 외의 다른 도메인에 대해 자연어 supervision을 활용했다. Stroud et al(2020)은 이미지 대신 비디오와 설명 텍스트를 짝짓는 시스템을 학습시켜 대규모 representation learning을 탐구했다. 여러 작업들이 비디오에 대해 dense spoken 자연어 supervision을 사용하는 것을 탐구했다. CLIP과 함께 고려될 때, 이러한 작업은 대규모 자연어 supervision이 많은 도메인에 대해 고품질 인식 시스템을 학습하는 유망한 방법임을 시사한다. Alayrac et al(2020)은 raw 오디오를 추가 supervision 소스로 추가하여 이러한 연구 방향을 추가 모달로 확장했으며, 3가지 supervision 소스를 결합하는 것의 이점을 시연했다.

CLIP에 대한 우리 연구의 부분으로 우리는 새로운 이미지-텍스트 쌍의 데이터셋을 구축했다. 이미지-텍스트 검색에 대한 현대적 작업은 Pascal1K, Flickr8K, Flickr30K 같은 crowd-sourced 문장 레벨 이미지 캡션 평가 데이터셋의 집합에 의존한다. 그러나 이러한 데이터셋은 여전히 상대적으로 작고 달성 가능한 성능에 한계가 있다. 더 큰 데이터셋을 자동적으로 생성하는 여러 방법이 제안되었으며, Ordonez et al(2011)은 주목할만한 초기 예제이다. 딥러닝 시대에 Mithun et al(2018)은 인터넷에서 수집된 추가적인 (이미지, 텍스트) 쌍의 집합이 검색 성능을 개선할 수 있음을 시연했고, Conceptual Captions, LAIT, OCR-CC 같은 새로운 자동적으로 구축된 데이터셋이 생성되었다. 그러나 이러한 데이터셋은 여전히 훨씬 더 공격적인 필터링을 사용하거나 OCR 같은 특정 작업에 맞게 설계되어 결과적으로 1-10M 학습 예제를 가진 WIT 보다 여전히 훨씬 작다.

CLIP에 관련된 아이디어로 webly supervised learning이 있다. 이 연구 방향은 이미지 검색 엔진에 쿼리하여 용어를 검색하고 반환된 이미지에 대해 쿼리를 라벨로 사용하여 이미지 데이터셋을 구축한다. 이러한 대규모이지만 노이즈 있는 라벨링된 데이터셋에 학습된 분류기는 더 작지만 조심스럽게 라벨링된 데이터셋에서 학습된 것과 경쟁적이다. 이러한 이미지-쿼리 쌍은 종종 표준 데이터셋의 성능을 개선하기 위한 추가적인 학습데이터로써 사용된다. CLIP도 데이터셋 생성 프로세스의 일부로 검색 쿼리를 사용한다. 그러나 CLIP은 단지 쿼리만이 아니라 이미지와 함께 나타나는 full text 문장을 supervision으로 사용한다. 쿼리는 종종 단일 word 또는 짧은 n-gram이다. 또한 CLIP에서 이러한 단계를 text-only 쿼리로 제약하여 sub-string 일치만 찾는 반면, 대부분 webly supervised 작업은 자체적인 복잡한 검색과 필터링 파이프라인을 갖는다. 이것은 종종 computer vision 시스템을 포함한다. 이러한 연구 방향에서 ‘Learning Everything about Anything: Webly-Supervised Visual Concept Learning’은 CLIP과 주목할만한 유사한 야망과 목표를 갖는다.

마지막으로 CLIP은 vision과 언어의 결합 모델을 학습하는 최근의 활발한 활동과 관련있다. 이 연구 방향은 visual question answering, visual commonsense reasoning, multi-modal entailment 같은 복잡한 downstream task를 해결하는 측면에서 vision과 언어를 풍부하게 연결하는데 초점을 맞춘다. 이러한 접근은 인상적으로 엔지니어링된 모델을 활용하는데, 이러한 모델들은 일반적으로 image feature 모델, region proposal/object detection model과 BERT 같은 pre-trained masked language model 등 3개(이상) pre-trained 하위시스템을 결합한다. 이러한 시스템은 그 후 이미지-텍스트 쌍에 대한 다양한 학습 목적을 통해 결합으로 fine-tune 되고 앞서 언급한 task에 적용되여 인상적인 결과를 달성한다. 반면 CLIP은 자연어 supervision을 통해 처음부터 visual 모델을 학습하는 것에 초점을 맞추며 joint attention 모델로 두 도메인을 densely 으로 연결하지 않는다. CLIP 모델에서 이미지와 텍스트 도메인 사이의 유일한 상호작용은 학습된 joint embedding 공간에서 dot product 뿐이다. 우리는 CLIP 이 연구 방향과 결합되는 것에 흥분된다.

9. Conclusion

우리는 NLP에서 task-agnostic web-scale pre-training의 성공을 다른 도메인으로 전이 가능할지 여부를 조사했다. 우리는 이 공식을 채택하면 computer vision의 영역에서도 유사한 행동이 나타난다는 것을 발견했으며 이 연구 방향의 사회적 함의에 대해 논의한다. CLIP 모델은 학습 목적을 최적화하기 위해 pre-train 동안 광범위한 task를 수행하는 방법을 학습한다. 이 task learning은 자연어 prompting을 통해 활용되어 많은 기존 데이터셋에 zero-shot 전이를 가능하게 한다. 충분한 스케일에서 이것의 성능은 task 특정 supervised 모델과 경쟁적이지만, 여전히 많은 개선의 여지가 남아 있다.

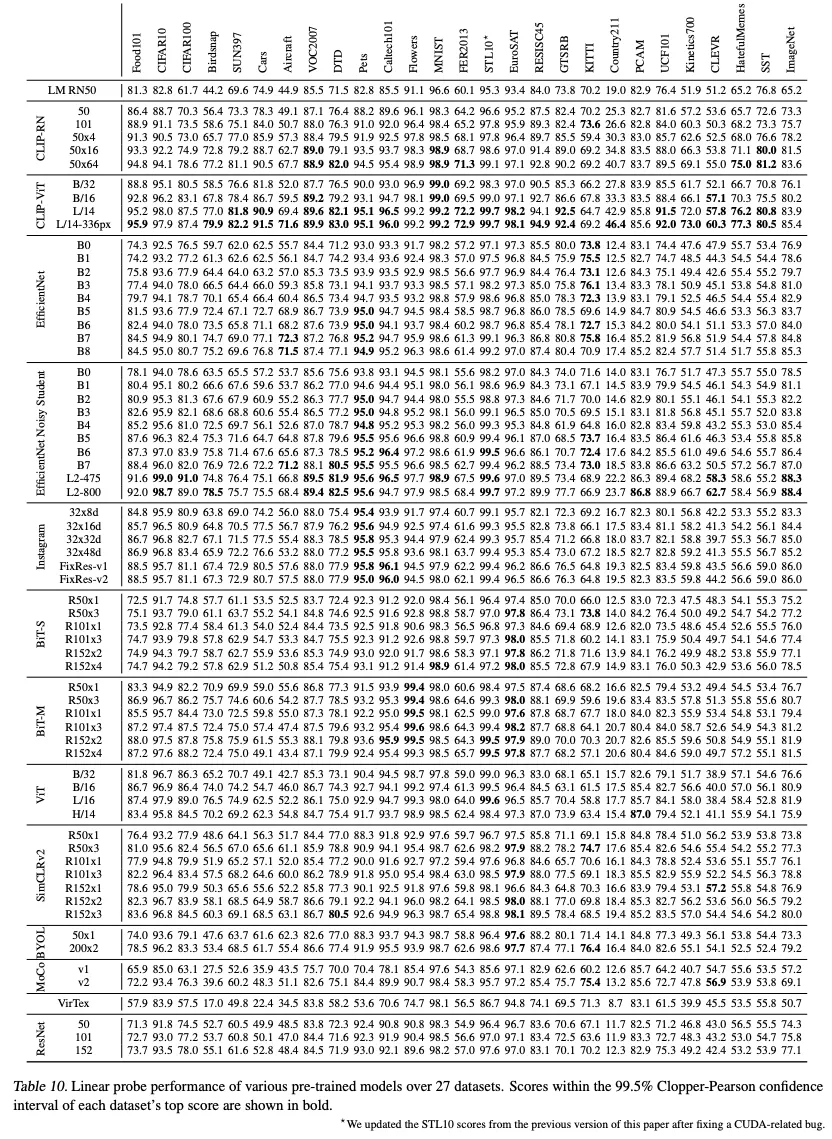

A. Linear-probe evaluation

우리는 이 논문에서 보여준 linear probe 실험에 대해 데이터셋의 목록과 평가를 위해 사용된 모델을 포함한 추가 상세를 제공한다.

A.1. Datasets

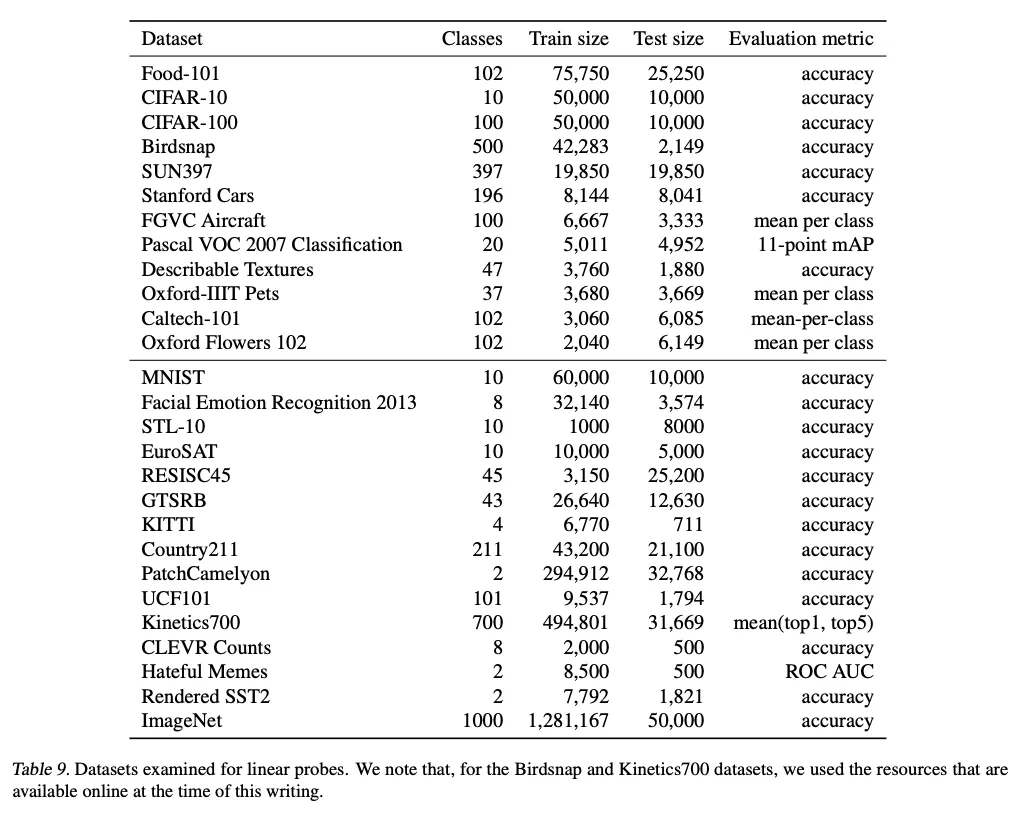

우리는 Kornblith et al(2019)에서 소개된 잘 연구된 평가 모음에서 12개 데이터셋과 더 다양한 분포와 task에 대한 모델의 성능을 평가하는 측면에서 15개 추가 데이터셋을 사용한다. 이러한 데이터셋은 MNIST, Facial Expression Recognition 2013 dataset, STL-10, EuroSAT, NWPU-RESISC45 데이터셋, German Traffic Sign Recognition Benchmark(GTSRB) 데이터셋, KITTI 데이터셋, PatchCamelyon, UFC101 action recognition 데이터셋, Kinetics 700, CLEVR 데이터셋의 2500 랜덤 샘플, Hateful Memes 데이터셋과 ImageNet-1k 데이터셋을 포함한다. 2가지 비디오 데이터셋(UFCF101과 Kinetics700)을 위해 우리는 입력 이미지를 각 비디오 클립에 대한 중간 프레임으로 사용한다. STL-10과 UCF101은 각각 10과 3의 여러 pre-trained train/validation/test 분할을 갖고 우리는 모든 분할에 대한 평균을 리포트 한다. 각 데이터셋과 해당하는 평가 메트릭은 Table 9에 제공된다.

추가적으로 우리는 Country211과 Rendered SST2라 부르는 두 개의 데이터셋을 생성한다. Country211 데이터셋은 시각 representation의 geolocation 능력을 평가하도록 설계되었다. 우리는 YFCC100m 데이터셋을 필터링하여 최소 300개의 GPS 좌표를 갖는 사진을 갖는 211개 국가를 찾는다(ISO-3166 국가 코드를 갖도록 정의된). 그리고 211개 카테고리의 균형잡힌 데이터셋을 구축한다. 각 나라별로 학습에 대해 200개 사진, 테스트에서 100개 사진을 샘플링한다.

Rendered SST2 데이터셋은 visual representation의 OCR 능력을 측정하도록 설계된다. 이것을 하기 위해 우리는 Stanford Sentiment Treebank 데이터셋에서 문장을 사용하여 이미지에 그것을 렌더링한다. 흰색 배경에 검은색 글자로, 448x448 해상도로. 이 데이터셋에서 두 개의 샘플 이미지는 그림 19 참조.

A.2. Models

위의 리스트업된 데이터셋의 결합에서 우리는 linear probes를 사용하여 다음 모델의 시리즈를 평가한다.

LM RN50

이것은 가장 작은 contrastive 모델에서와 같이 ResNet-50 아키텍쳐를 사용하면서도 contrastive loss 대신 autoregressive loss를 사용하는 multimodal 모델이다. 이것을 위해 CNN에서 출력을 4개 토큰으로 투영된다. 그 다음 이것을 텍스트 토큰을 autoregressively 예측하는 언어 모델에 prefix로 공급한다. 학습 목적을 제외하고 이 모델은 CLIP과 동일한 데이터셋에서 동일한 epoch 수로 학습된다.

CLIP-RN

5가지 ResNet-based contrastive CLIP 모델이 포하된다. 이 논문에서 논의된대로, 첫 두 모델은 ResNet-50과 ResNet-101을 따르고 다음 3개 모델에 대해 EfficientNet style 스케일링을 사용한다. 모델 width, layer 수, 입력 해상도를 동시에 조정하여 약 4배, 16배, 64배 계산량을 포함하는 모델을 얻는다.

CLIP-ViT

우리는 Vision Transformer 아키텍쳐를 이미지 encoder로 사용하는 4가지 CLIP 모델을 포함한다. 우리는 224-by-224 픽셀 이미지에서 학습된 3가지 모델을 포함한다. ViT-B/32, ViT-B/32, ViT-L/14. 그리고 ViT-L/14 모델은 336-by-336 픽셀 입력 이미지에서 fine-tune 된다.

EfficietNet

우리는 원래의 EfficientNet 논문에서 9개 모델(B0-B8)을 사용하고 noisy-student 변종(B0-B7, L2-457와 L2-800)도 사용한다. 가장 큰 모델(L2-475와 L2-800)은 입력 해상도가 각각 475x475 800x800 픽셀이다.

Instagram-pretrained ResNeXt

우리는 Mahajan et al(2018)에 의해 공개된 4개 모델(32x8d, 32x16d, 32x32d, 32x48d)를 사용하고 더 고차원 입력 해상도를 사용하는 그들의 2가지 FixRes 변종도 사용한다.

Big Transfer (BiT)

우리는 ImageNet-1k과 ImageNet-21k 데이터셋에서 학습된 BiT-S와 BiT-M 모델을 사용한다. BiT-L에 대한 모델 가중치는 공개적으로 접근가능하지 않다.

Vision Transformer (ViT)

우리는 ImageNet-21k 데이터셋에서 pre-train 된 4개 ViT checkpoint를 포함한다. 즉 ViT-B/32, ViT-B/16, ViT-L/16, ViT-H/14. 우리는 JFT-300M에서 학습된 그들의 최고 수행 모델이 공개적으로 접근가능하지 않음에 유의한다.

SimCLRv2

SimCLRv2 프로젝트는 다양한 설정에서 pre-trained와 fine-tuned 모델을 공개했다. 우리는 selective kernel을 사용한 7개 pre-train only 체크포인트를 사용한다.

BYOL

우리는 BYOL의 최근 공개된 모델을 사용한다. 구체적으로 그들의 50x1과 200x2 checkpoint

Momentum Contrast (MoCo)

우리는 MoCo-v1과 MoCo-v2 checkpoint를 포함한다.

VirTex

우리는 VirTex의 pre-trained 모델을 사용한다. VirTex가 CLIP-AR과 유사한 모델 설계를 갖지만 MSCOCO에서 고품질 캡션의 1000배 더 적은 데이터셋에서 학습되었음에 유의한다.

ResNet

우리는 공개된 원래의 ResNet checkpoint을 추가한다. 즉 ResNet-50, ResNet-101, ResNet-152

A.3. Evaluation

우리는 각 모델의 마지막에서 두 번째 레이어에서 취해진 이미지 feature를 사용하고 제공된 분류 레이어는 무시한다. CLIP-ViT 모델의 경우 그림 3의 I-F에 해당하는 embedding 공간에 linear projection 이전에 feature를 사용한다. 우리는 scikit-learn의 L-BFGS 구현을 사용하여 logistic regression classifier를 학습하고 최대 1000 iteration을 수행하고 각 데이터셋에 대한 해당 메트릭을 리포트한다. L2 regularization 강도 는 과 사이의 범위에서 96개 log spaced 단계를 사용하여 validation 집합에 대한 하이퍼파라미터를 sweep 하여 결정한다. 우리는 sweep의 계산량을 줄이기 위해, 로 시작하여 피크 주위에서 간격을 반복적으로 절반으로 줄이는 파라메트릭 binary search를 수행하여 decade 당 8 step의 해상도에 도달할 때까지 수행한다. 하이퍼파라미터 sweeps는 각 데이터셋의 validation 분할에서 수행된다. validation 분할과 테스트 분할을 포함한 데이터셋의 경우, 제공된 validation set을 사용하여 하이퍼파라미터 검색을 수행한다. validation 분할을 제공하지 않거나 테스트 데이터에 대한 라벨을 공개하지 않은 데이터셋의 경우 학습 데이터셋을 분할하여 하이퍼파라미터 검색을 수행한다. 최종 결과에 대해 validation 분할을 다시 학습 분할과 결합하고 사용되지 않은 분할에 대한 성능을 리포트한다.

A.4. Results

개별 linear probe score는 Table 10에 제공되고 그림 20에 그려진다. 최고 성능 CLIP 모델은 ViT-L/14 아키텍쳐와 336x336 픽셀 이미지를 사용한다. 이것은 27개 데이터셋 중 21개에서 최첨단을 달성한다. 즉 각 데이터셋의 최상위 점수 중심으로 Clopper-Pearson 99.5% 신뢰 구간에 포함된다. 많은 데이터셋에서 CLIP은 다른 모델보다 상당히 잘 수행되며, 이미지 분류에 대한 전통적인 pre-training 접근에 대한 자연어 supervision의 이점을 시연한다. linear probe 결과에 대한 더 상세한 내용은 섹션 3.2 참조.